AI in week 51

Geniet extra van deze nieuwsbrief want de komende drie weken geniet ik even van de vakantie en doe ik alleen korte specials en misschien als ik zin heb net als vorig jaar ook een jaaroverzicht.

Er is weer een Engelse vertaling deze week!

Ja, maar nee

AI in de wetenschap, ik ben zoals bekend geen fan. Dus dan zou je denken dat een vlammend pleidooi van Julian Togelius, professor aan New York University, wel resoneerde. Hij stond naar eigen zeggen op op NeurIPS, de conferentie over AI, toen andere wetenschappers "discussed how they plan to replace humans at all levels in the scientific process" en noemde dit plan kwaadaardig ("evil").

Nu ben ik het daar natuurlijk mee eens, al vind ik evil een beetje een vreemde formulering. De gevolgen zijn, zoals ik twee weken terug schreef, waarschijnlijk veel slechtere wetenschap, waarvoor niemand meer de tijd kan opbrengen om het te controleren, en om erover te praten. De grootste zorg van Togelius is echter niet de kwaliteit van de kennis die uit AI gaat komen, maar het leven van de wetenschappers.

If you take the human out of the loop, meaning that humans no longer have any role in scientific research, you're depriving them of the activity they love and a key source of meaning in their lives

AI gaat zeker weten, aldus Togelius dus (niet aldus Hermans), kanker uiteindelijk wel genezen (ok kan) maar ook, hou je vast, onsterfelijkheid mogelijk maken, en kernfusie en space travel (ik neem aan dat hij daar voor iedereen mee bedoelt want we kunnen op zich de ruimte al in). Maar het is niet erg dat het langzamer gaat omdat mensen het doen, want anders zou het niet leuk zijn voor mensen!

Making human intellectual or creative work redundant is something we should avoid when we can, and we should absolutely avoid it if there are no equally meaningful new roles for humans to transition into.

Ja, je zou je nog gaan vervelen als wetenschapper, want er zijn echt geen equally meaningful new roles. Geen lerarentokort ofzo, nee, of handjes nodig in de zorg, of electriciens. Wat moet je nou toch doen als je papers automatisch uit de papermachine-rollen?

Begrijp me niet verkeerd, ik ben voor waardig werk voor iedereen, ook wetenschappers, maar Togelius gaat hier wel even met 130 km/uur (het mag weer) voorbij aan de vraag óf AI wetenschap kan bedrijven, en wat voor wetenschap dat dat zou zijn.

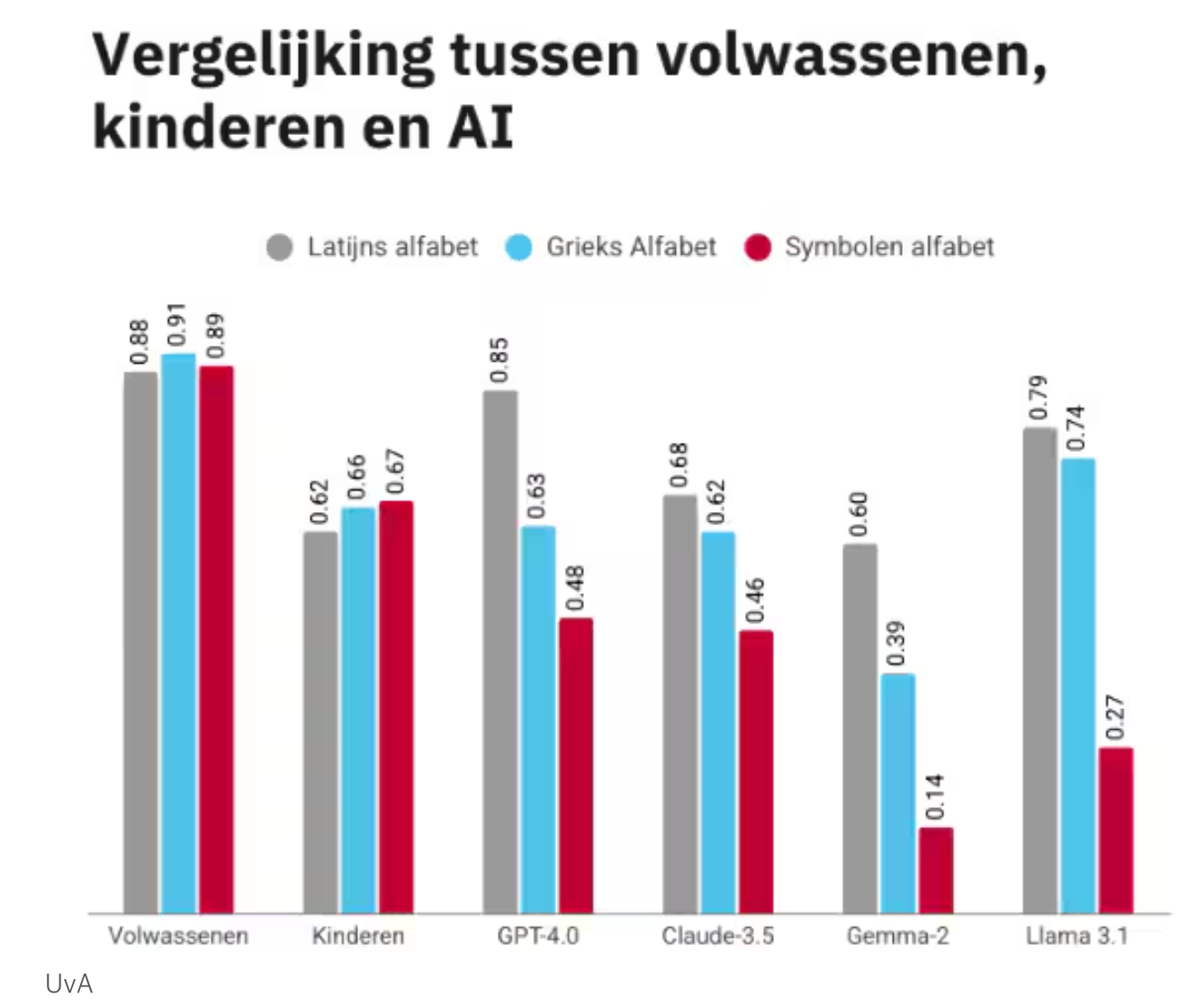

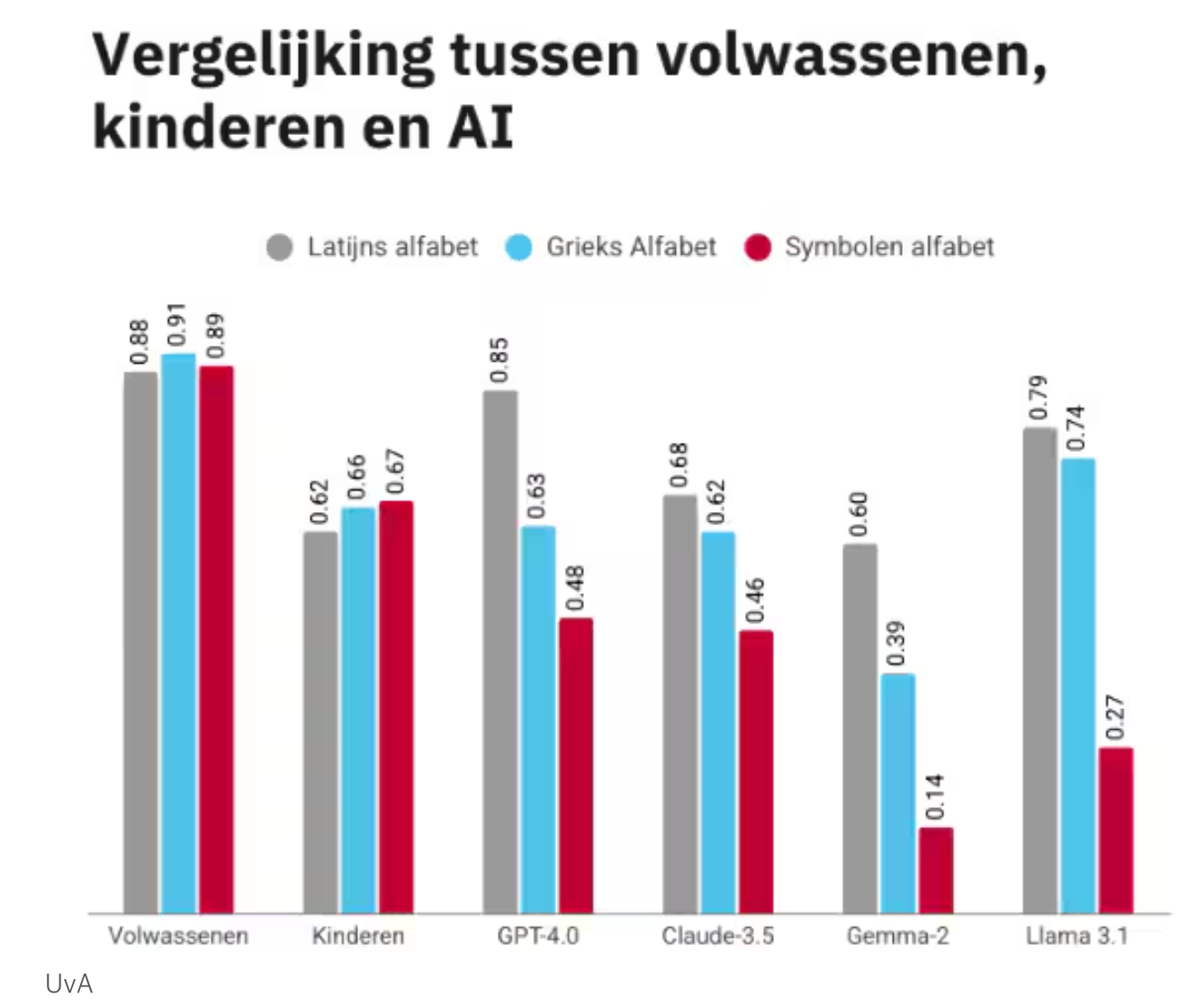

Want zo goed is AI helemaal niet, als het gaat om redeneren met nieuwe informatie, wat je als wetenschapper hopelijk vaak doet, dan is AI niet beter dan een achtjarige, blijkt uit onderzoek van oa de UvA beschreven in Volkskrant deze week. Voor een letterpuzzel doet een AI het prima op ons Latijnse alfabet, maar voor een onbekend alfabet gaat het totaal de mist in:

Daaraan zien we maar weer eens dat een AI niet denkt, maar op basis van bekende data gaten vult. Lijkt mij niet handig om met zo'n systeem naar mars te vliegen...

Vriend Marc Dingemanse–ik schreef eerder over zijn werk rondom het woordje huh—contextualiseert de bevindingen weer eens scherp:

Mensen zien makkelijk patronen in reeksen. Dat leidt er misschien ook toe dat ze extra ontvankelijk zijn voor het idee dat de woorden van ChatGPT met intentie zijn geformuleerd, vermoedt Dingemanse. ‘Terwijl het uiteindelijk gewoon woordenreeksen zijn, geplukt uit een wolk van waarschijnlijkheid, en wij het zijn die de puzzel leggen en de betekenis erin zien.’

Ja, het denken dat lijkt te gebeuren, daarvoor doen mensen de heavy lifting, net als het toekennen van emoties in figuurtjes.

Nog even terug naar Togelius, zijn gebrombrom over zijn werkplezier. Wat me er zo aan stoort is dat ik dacht dat het doel van de wetenschap was om goede en zinvolle kennis te maken, en dat je dan als wetenschapper dus ook een soort verantwoordelijkheid hebt om het proces van de wetenschap steeds te bevragen en waar mogelijk te verbeteren. I know ik was horribly naïef.

Hoe kan je nou zo dapper zijn dat je wel opspringt om je te verzetten tegen AI—lovenswaardig tegen de stroom in—maar dan niet beginnen over het feit dat bij een AI conferentie (ICLR) een geschatte een op de vijf reviews met AI geschreven lijkt en bijvoorbeeld referenties hallucineert. En al die hallucinaties, die komen, natuurlijk, ook in echte papers terecht, want als een reviewer zegt dat jij "Jansen 2023" moet citeren, dan is veruit de eenvoudigste oplossing om dat gewoon te doen. Vind je dat paper niet, dan neem je misschien wel, horribly naïef, aan dat de reviewer verstand van zaken heeft en dat het aan jou ligt dat je dat paper niet kan vinden. En zo zijn we dus in de wereld waarin een boek over AI en ethiek van uitgever Springer met AI gemaakt bleek en ook vol zat met niet-bestaande referenties. Dat is geen hypothetisch toekomstprobleem, dat speelt nu.

Slop

In Nederland was hallucineren het woord van 2025, in het Engels viel de keuze van woordenboek Merriam Webster ook op een AI woord, maar op een ander: slop:

digital content of low quality that is produced usually in quantity by means of artificial intelligence

AI slop kruipt inmiddels in alle hoeken en gaten van het internet. Zoek je op Google dan popt het vanzelf op, ook als je daar niet om vraagt, las je niet alleen al eerder in deze nieuwsbrief over mijn eigen paper, maar natuurlijk ook over het aaltje dat zomaar je zoekresultaten in glibbert, en over de Camino van wel of niet Niewierra, maar het was maar was verleden week ook in EenVandaag te zien waar presentator Rik van de Westelaken vertelt dat hij volgens AI een relatie heeft met zijn styliste Hanna.

Dit is dan nog, als het het positief bekijkt, onopzettelijke slop, maar in andere gevallen wordt het doelbewust ingezet voor nepnieuws, zo schreef NRC.

Waar je zou verwachten dat grote bedrijven zich verzetten tegen het gebruik van hun content, verraste mij het nieuws deze week totaal dat Disney een MILJARD in openAI investeert, volgens de altijd scherpe blog 404 media in de slopification van hun brand. Dat is vooral verrassend omdat Disney traditioneel heel weinig toeliet met hun ip, om begrijpelijke redenen. Maar dat is dus nu voorbij:

Disney [...] which has been notoriously protective of its intellectual property, opened up the video generator, saw the videos featuring Nazi Spongebob and criminal Pikachu, and decided: We want in.

OpenAI probeerde in Sora gebruikers nog te verhinderen om content te veel lijkend op materiaal van Disney (en andere rechthebbenden) te blokkeren maar dat is notoir moeilijk, en dus, zo schrijft 404, moeten ze gedacht hebben "if you can’t beat the slop, become the slop". De investering betekent niet alleen dat je Disneycontent op Sora en ChatGPT mag synthesizen, Disney gaat het zelf ook publiceren op hun kanalen. En niet alleen Disney valt hieraan ten prooi, ook StackOverflow, de site voor vraag en antwoord, gaat samenwerken met openAI, en de Washington Post (ok, misschien niet echt meer een bastion van goede journalistiek nu Jeffrey Jeffrey Bezos de scepter zwaait) gaat met AI gepersonaliseerde podcasts maken.

En wie moet er uiteindelijk dealen met al die slop? Wij. De kosten van die onzin komen nu bij gebruikers te liggen, niet eens zozeer de gebruiker van AI zelf, die weet nog dat hij met AI-uitvoer te maken heeft en in theorie alles nog echt gaan controleren maar bij onschuldige gebruikers verder in de keten die niet weer wat er uit AI komt en wat niet:

[T]he cost of producing these outputs didn’t disappear. It’s just displaced onto the worker downstream of the AI user [...] The worker downstream now has no idea where errors might be hiding, which parts of the code or report were reliable and which risk being a hallucination.

Bovenstaande schrijft designer Pavel Samsonov in zijn nieuwsbrief. Als jij zo snel mogelijk zoveel content wil schrijven, dan zadel je andere mensen op met de verplichting alles te controleren, en dat vernielt leesplezier.

Chatbots maken fouten, punt. Het bewijs stapelt zich op en op, Trouw meldde deze week dat zelfs de beste chatbots maar maximaal een derde van de antwoorden klopt (Gemini 3), en nobody cares. AI-grifters die boeken of lezingen verkopen blijven op Linkedin kakelen over "verantwoord gebruik" en "beter prompten", maar er valt niet op te prompten tegen iets dat random foute antwoorden geeft.

Dat zeg ik niet alleen, dat schrijven ook onderzoekers van Carnegie Mellon. Prompten door een persona te beschrijven a la "speel een kritische tegenlezer" "does not improve model performance across a range of questions compared to the control setting where no persona is added" Het effect van deze prompts is "largely random". Ja, stochastic parrot is gonna stochast...

De oplossing is dan ook niet technologisch, sluit Samsonov af.

This is not a technology issue; no amount of model improvements will make this okay. It is an ethics issue, and the only way to fix it is to fix your heart.

De echte oplossing is dan misschien geen technologie, maar technologie kan wel helpen! Echt helemaal klaar met al dat gezeur over AI? Installeer deze plugin die iedere mention van AI verandert in eentje over basketballer Allen Iverson.

De pijn van weten dat het beter kan

Ow mensenkinderen, wat een stuk is dit! Geschreven door programmeur Raf, over hoe het voelt als je steeds bij alle software die je gebruikt denkt: dit moet beter kunnen. Voornamelijk herkenbaar als je zelf programmeur bent denk ik.

Zeker het stuk Technical Capability as a Moral Weight, dat je steeds bij alles dat het niet doet voelt dat het niet ok is:

Those things are not just questions, they are accusations. And, unfortunately, they do not stop.

Het is zoals ik aan het begin van het jaar schreef, ik zie een mooie nieuwe tool voor het leren van letters en ik moet meteen proberen of het werkt in het Arabisch, en als dat het niet doet snap ik waarom en erger ik me groen en geel.

En het droevige is eigenlijk dat zelfs mensen die kunnen maken, dat zo weinig doen. Ik sprak laatst vriendin Fenia Aivaloglou die jarenlang als programmeur gewerkt heeft, en die zich erover beklaagde dat als je je kind achter de smart-tv zet, ze dan verleid worden tot eindeloos rommel bingen. Anders dan vroeger toen wij "domme" tv keken is een serie nooit afgelopen

Wat ik wil zei ze, is dat mijn zoon uit iets van drie opties kan kiezen, een curated collection, dus geen auto-recommendations. En net als vroeger: op is op, is het progamma afgelopen, dan stopt de software gewoon. Misschien start er een muziekje, of een teller tot de volgende aflevering, of een leuke puzzel of quiz ofzo. Ze fantaseerde meteen al verder: misschien kun je met bevriende ouders curated collections delen.

Tot ik zei: maar Fenia, jij kan toch programmeren? Jij zet dit toch zo in een middag in elkaar? (PS vind je dit een cool idee! Fenia komt graag met je in contact via haar Linkedin!). Maar dat kwam gewoon niet echt in haar op, want zo weinig mensen, zelfs die het kunnen doen het. Onder andere omdat het heel erg lastig is om die software dan ook echt op je smart-tv te krijgen. Die ecosystemen zitten meestal potdicht en het is een heel gedoe om wat voor elkaar te krijgen.

Maar eerlijk is eerlijk, ik denk zelf 0ok niet altijd aan dingen echt gaan programmeren, suf is dat! Misschien is het je opgevallen dat er sinds twee weken linkjes achter iedere header staan, als je eroverheen hovert (het roze # tekentje):

Ik wilde die al lang hebben, want zonder dat knopje moet je, als wilt deeplinken en dat wil ik nogal eens, de url overtypen met de hand, en spaties in streepjes veranderen, zo #de-lezersvraag-hoe-is-je-nieuwsbrief-anders-dan-een-paper-of-een-tweet. Als de header lang is, is dat een hoop werk.

Nu werkt een goede vriend van mijn toevallig bij Ghost (dat is eigenlijk niet toevallig want door hen zit ik op Ghost!), en ik vroeg hem of hij dat niet even kon maken voor mij. Nou, zei hij, misschien kan je dat zelf wel! Die aanmoediging had ik dus echt nodig om aan de slag te gaan. En zo moeilijk was het uiteindelijk niet. Met een beetje zoeken vond ik een idee op hun forum met een codevoorbeeldje erbij.

Lekker, dat kan ik zo met 'code injection' invoeren. Dan moet je al weten dat er zoiets is als code invoeren in Ghost, en hoe dat precies moet. Je moet de codes namelijk opdelen in css-code voor opmaakt, en Javascript-code voor functionaliteit. Weet je dat niet dan krijg je het voorbeeld al niet ingevoerd.

Maar ai! Toen ik dat had gedaan, zag mijn site er opeens heel gek uit, alles was supersmal. Nog maar eens even goed lezen wat ik ongezien in mijn website heb geplakt.

body {

max-width: 500px;

margin: 1rem auto;

padding: 2rem;

font: 300 100%/1.6 system-ui;

}

Ah ja, tuurlijk, daar staat maximale breedte 500 pixels. Dat kon ik snel vaststellen omdat ik weet dat body over de inhoud van je site gaat en dat 500px niet zo breed is. Waarom staat er code bij over de breedte van de pagina, terwijl wat ik wil een linkje toevoegen is? Ow, ik zie het al, anders ziet het voorbeeld er niet zo mooi uit, maar in het echt heb je die niet nodig.

Ok, nu zijn we er wel toch? Nee... er is nog niks veranderd! Blergh. Wat nu? Een 'gewoon mens' die een website heeft loopt nu waarschijnlijk vast, want er is geen manier om te zien waarom het niet werkt. Dan moet je dus al weten dat je in de meeste browsers een "programmeursmodus" hebt om onder water mee te kijken.

En daar zag ik dus de reden dat het niet werkt, een error! Uncaught ReferenceError: $ is not defined Hoe komt dat? $ dat heeft iets met jquery te maken, een manier om met Javascript de structuur (DOM) van de website uit te lezen. In het voorbeeld laden ze die code niet, omdat CodePen dat zelf al ingebakken heeft, maar ik moet dat wel doen.

StackOverflow weet raad, ik moet gewoon even die jquery linken! Ik lees dit antwoord en kan meteen inschatten dat is de waarschijnlijke oorzaak is; ik heb vaker dit soort fouten opgelost. Maar, hier nemen ze weer aan dat ik de JavaScript op mijn site ga uploaden, dat zou ik wel kunnen doen maar dat is een gedoe, ik wil liever een CDN gebruiken, een plek op internet waar al codes klaar staan. Moet je dus weten wat een CDN is, waarom die nuttig zijn, en dat je eentje van Google (die verderop de pagina vermeld staat) wel kan vertrouwen, althans in de betekenis dat die niet waarschijnlijk offline gaat.

Ik zou nog wel even door kunnen gaan, zo leunde het voorbeeld op kopjes die h3 heten maar ik heb h2 op mijn site, en op mijn site heet de inhoud geen .article-content maar .gh-content. Dat moest ik met de programmeursmodus weer opzoeken, en extra code schrijven om te tellen wat er al gevonden was. 0.2 marge vond ik ook niet zo mooi, en ik wil de link aan de achterkant en niet aan de voorkant, dus nog even de css aanpassen. En toen zag ik op een andere Ghost site een nog mooier voorbeeld met een "hover over" zodat het tekentje alleen verschijnt als je over de header wappert met je muis, dus daar even met de developers mode de code van gestolen!

Al met al ben ik een uurtje bezig geweest om een simpel link-icoontje invoegen op mijn site, maar dat kon ik dat alleen doordat ik al heel veel weet over web-programmeren. LLM-fans zouden misschien zeggen dat dat met een code-chatbot ook wel gelukt zou zijn, en misschien is dat zo, maar zeker niet in een uurtje, want als je niks weet, je moet voortdurend verder lezen, zoeken en uitpluizen. Een simpel "$ betekent jquery" is voor mij één seconde denkwerk, maar dat kan zo een half uur chatten zijn als je niet weet wat je niet weet en dus ook niet weet wat je moet vragen. "prompt engineering" komt nooit verder dan de in jouw langetermijngeheugen al opgeslagen kennis.

En in Ghost kan je dan nog scripten! Regelmatig erger ik me aan menuutjes in een app waar míjn favoriete opties niet bovenaan staan, en grom ik tegen mijn scherm dat ik daar helemaal niks aan kan doen al zou ik het willen, zelfs al zou ik het zo voor mekaar hebben als ik bij de code zou kunnen.

Dus alleen maar zien en weten dat het beter kan is nog niet genoeg, je hebt kennis nodig, maar vooral ook toegang. Vroege computerpioniers vonden dat je, als je software gebruikt, het morele recht hebt om ook de code erbij te krijgen die je dan naar hartelust kan aanpassen. Dat klinkt in de huidige totaal dichtgetimmerde digitale wereld misschien absurd, maar bij de meeste producten werkt het natuurlijk wel zo. Koop jij een broek, dan mag je die zelf korter knippen, afscheuren, verven. Je kan je fietsspaken met rietjes of crèpepapier versieren, wie doet je wat?!

Maar op de computer ben je overgeleverd aan wat de makers van software toevallig dachten dat handig was; een vloek als je weet hoe het beter kan, niet alleen de software zelf maar ook de wereld.

Kort over taalbias in GPT

En dat programmeren en het vertrouwen dat je dat kan helpt niet alleen als ik iets wilt bouwen, maar ook als je iets wilt begrijpen! Duitse programmeur Jonas Villwock vroeg GPT vragen over gezondheid in het Duits, maar hij kreeg steeds links naar Engelstalige bronnen. In plaats van denken, he wat gek? Dacht hij: he ik duik hierin om te ontdekken hoe het zit, met PeekAI, een tool waarmee je (tegen betaling zo lijkt het) kan bekijken wat AI voor antwoord geeft op vragen, zodat je kan ontdekken of jouw "brand" wel goed naar voren komt. Er ontstaat blijkbaar een soort search-engine optimization markt voor LLMs, maar dat terzijde.

Villwock dook erin en analyzeerde 600 bronnen van ChatGPT, Perplexity, and Google AI overzichten. En wat bleek? Geen verrassing natuurlijk, maar Engelstalige bronnen kregen een enorme prioriteit, zelfs als je dus in het Duits chat. Dat is een probleem want, zo schrijft hij op Linkedin:

People can't verify information in their own language when it matters most.

En er zijn maar heel weinig sites die vaak als bron worden herkend, maar 5% van de domeinen komt bij alledrie de chatbots voor, en het zijn nooit wetenschappelijke bronnen:

They skip the science and rely on secondary sources that have already simplified it.

Lees zijn hele analyze op zijn blog, waaruit ook weer hele grote verschillen tussen chatbots blijkt trouwens. ChatGPT en Perplexity verschillen enorm!

Events

(herhaling!) Alvast voor in de agenda voor na de kerstvakantie:

- 16 januari: Bij Onderwijsinzicht, georganiseerd door Kennisnet mag ik spreken over de impact van AI op leren. Ik gaf voorafgaand alvast een kort interview!

- 12 februari geef ik een keynote op NWO Insight Out, een congres voor vrouwen in de betawetenschappers (STEM) georganiseerd door NWO. Ik zal het daar (natuurlijk!) hebben over de beta-cultuur en het effect daarvan op hoe we werken en wat we onderzoeken in de wetenschap.

- 26 maart spreek ik op de Lerarendag Digitale Geletterdheid. Die dag proberen we leraren te ondersteunen bij het vormgeven van digitale geletterdheid op school.

Goed nieuws

Ik heb regelmatig kritiek op de VU, maar er zijn ook dingen die we echt onwaarschijnlijk goed doen, zoals bijna geen samenwerkingen meer met de fossiel industrie. Dat blijkt gelukkig ook uit deze hele gedetailleerde analyse in Trouw. Helaas blijken er nog een hele hoop andere universiteiten in Nederland te zijn die wel op de een of andere manier iets met fossiel doen. Het stuk is fijn, maar nog mooier is de bijbehorende, interactieve datavisualisatie, waarin je langs verschillende universiteiten kan klikken om te kijken wie welke belangen dient. En dan vind je dus zo een hoogleraar uit Twente die in Volkskrant schreef dat universiteiten hun morele kompas niet op onderzoek moeten leggen, terwijl zijn eigen onderzoek door Shell gefinancierd werd. Dat, zo schreef hij, komt "het debat, en daarmee het onderwijs, ten goede komen." Ja, en misschien ook hemzelf, maar dat hij met Shell samenwerkte werd in dat stuk even niet vermeld. En dat is maar één voorbeeld, de visualisatie toont er talloze, maar geen van de VU, en dat stemt me blij en trots!

En wat ook blij maakt... Zelfs echte AI fans in programmeerland komen langzaam op hun enthousiasme terug!

Ook oud-collega Zef Hemel schreef een heerlijk stukje over programmeren met een LLM, het is net als stofzuigen met een Roomba, ja het doet wel wat maar als je een schoon huis wil, doe je het toch zelf.

Misschien geen verrassing dus dat er, zo blijkt uit onderzoek van BNR, nog genoeg vraag is naar programmeurs! Tussen 2020 en 2025 was de vraag naar programmeurs en AI specialisten met 18.000 vacatures twee keer zo hoog als in de vijf jaar daarvoor.

Programmeurs zijn niet de enige critici, want, aldus blog Extreme Tech gebruikt "almost nobody" CoPilot en moet Microsoft hun doelen dus fiks terugschroeven, in sommige gevallen met 50%. Dat komt dan wel vooral omdat mensen op chatGPT zitten of Gemini en niet omdat ze AI helemaal niet gebruiken, maar gezien hoezeer de CoPilot features de laatste tijd gepusht zijn in alle Microsoft-producten (bijvoorbeeld die irritante popups in Outlook om je mails samen te vatten) is het toch frappant. Blijkbaar klikken mensen daar dus echt niet op!

Ook in de zorg blijkt AI nog niet echt problemen op te lossen, schreef Volkskrant deze week over onderzoek van Erasmus dat maar liefst 1.263 papers over AI bekeek. Bijna geen van de ideeën hielp; 1.238 (98 procent) toepassingen leverde niks op. En dan kan je zeggen, goed dat mensen het proberen, maar dit is natuurlijk allemaal niet gratis, zowel direct—het proberen kost geld—als indirect—alle ballen op AI zorgt ervoor dat andere, vaak simpelere, toepassingen niet geprobeerd worden.

Meer goed nieuws is dat mensen zich toch redelijk druk blijven maken over lelijke AI slop. McDonalds trok bijvoorbeeld hun afgrijselijke slopvertentie terug.

En tenslotte, ik schrijf er niet vaak over want alles is zoveel, maar het gaat natuurlijk hard bergafwaarts met de vrijheid is Amerika, zoveel is wel duidelijk na het vijfde jaar Trump. Wat hartverwarmend dat er dappere mensen zijn, zoals de St. Susanna Parish kerk in Massachusetts, die uit hun kersttal de poppen weg hebben gehaald en vervangen door een poster met "ICE was here", ondanks de kritiek die ze daarop kregen onder andere van, je raadt het niet, het bisdom van Boston.

Slecht nieuws

Er is geen cloud, er is alleen iemand de computer van iemand anders. Dat weten we natuurlijk wel, maar soms is het allemaal zo makkelijk! Laat dit verhaal van Paris Buttfield-Addison een reminder zijn dat je altijd zelf je eigen backups moet maken op je eigen computer, want je toegang kan zomaar geblokkeerd worden (Buttfield-Addison kon na 5 dagen weer bij zijn bestanden, mogelijk ook door de aandahct die hij kreeg voor zijn post). Ook bij Meta ben je (uiteraard) niet veilig, Instagram verwijderde onlangs tientallen accounts van LHBTI-ers.

Wat zeker al weg is, is Google's programma om vrouwen te helpen in hun carriere, het Women Techmakers programma. En niet alleen is het afgeschaft, ook al hun werk is verwijderd van de website van Google, wat aangeeft dat het niet alleen gaat om bezuinigen maar ook om beeldvorming.

Wow, wat een droevig verhaal aan alle kanten. Een jonge vrouw wilde een abortus, wat bij de eerste behandeling niet lukte. Bij een tweede behandeling werd haar, ten onrechte zo bleek later, verteld dat het kindje niet meer leefde en dat ze vanzelf een miskraam zou gaan krijgen, dat gebeurde niet en uiteindelijk koos ze niet voor nog een behandeling. Ze diende een klacht in bij het medisch tuchtcollege en in de zitting kwam de volgende, absoluut geschifte, zin voor:

Ik heb ChatGPT gevraagd naar de kwaliteit van het toestel en ChatGPT zegt dat er niets mis mee is. Ik heb het gemist, ondanks mijn meer dan dertig jaar ervaring.

De mazelen-uitbraak zet door in de VS, de meeste gevallen treffen ongevaccineerde kinderen, zo ongelofelijk onnodig.

Geniet van je kerstdiner en tot in het nieuwe jaar wat betreft de gewone nieuwsbrieven!

English

Do enjoy this newsletter in full, because for the next three weeks I'll be enjoying a break and will only be writing specials and maybe, if I feel like it, just like last year, an annual review (Dutch).

Yes, but no

AI in science, as is well known, I am not a fan. So you might think that a passionate plea by Julian Togelius, professor at New York University, would resonate with me. He said he stood up at NeurIPS, a top conference on AI, when other scientists "discussed how they plan to replace humans at all levels in the scientific process", and called this plan evil.

Of course, I agree, although I find evil a heavy word to choose. The consequences, as I wrote two weeks ago, are likely to be that science will get worse, which no one will have the time to check or discuss. However, Togelius' main concern is not the quality of the knowledge that will come out of AI, but the lives of scientists.

If you take humans out of the loop, meaning that humans no longer have any role in scientific research, you are depriving them of the activity they love and a key source of meaning in their lives.

According to Togelius (not Hermans), AI will certainly cure cancer in the end (okay, maybe), but also make immortality possible, as well as nuclear fusion and space travel (I assume he means for everyone, because "humanity" of course can already go into space). But it's okay if it these things are discovered slower because people are doing it, because otherwise it wouldn't be fun for people!

Making human intellectual or creative work redundant is something we should avoid when we can, and we should absolutely avoid it if there are no equally meaningful new roles for humans to transition into.

Oh so boring your life will be, without any equally meaningful new roles? No teacher shortage or anything like that, no, or need for people in healthcare, or electricians. What are you supposed to do when your papers are printed by the paper machine automatically?

Don't get me wrong, I am in favor of dignified work for everyone, including scientists, but Togelius overlooks whether AI can do science, and what kind of science that would be.

Because AI isn't that good when it comes to reasoning with new information, which you hopefully do often as a scientist. According to research by the University of Amsterdam, among others, described in Volkskrant this week, AI is no better than an eight-year-old (Dutch). AI does well with our Latin alphabet for a letter puzzle, but it fails completely with an unknown alphabet:

This shows us once again that AI does not think, but fills in gaps based on known data. It doesn't seem wise to me to fly to Mars with such a system...

My friend Marc Dingemanse—I wrote earlier about his work on the word “huh”—once again contextualizes the findings sharply:

People easily see patterns in sequences. Dingemanse suspects that this may also make them extra receptive to the idea that ChatGPT's words are formulated with intention. “While ultimately they are just strings of words, plucked from a cloud of probability, and it is we who put the puzzle together and see meaning in it.” (translated from Dutch)

Yes, the thinking that seems to be happening, people do the heavy lifting for that, just like attributing emotions to geometric shapes.

But back to Togelius and his grumbling about his job satisfaction. What bothers me so much is that I thought the purpose of science was to acquire good and meaningful knowledge, and that as a scientist you therefore also have a kind of responsibility to constantly question the scientific process and improve it where possible. I know, I was horribly naive.

How can you be so brave as to jump up and oppose AI—bravely going against the zeitgeist—but then not mention the fact that at an AI conference (ICLR), an estimated one in five reviews appears to have been written by AI and, for example, hallucinates references.

And all those hallucinations, of course, also end up in real papers, because if a reviewer says you have to cite “Jansen 2023,” the easiest solution by far is to just do it. If you can't find that paper, you might horribly naively assume that the reviewer knows what they're talking about and that it's your fault you can't find it. And so we find ourselves in a world where a book on AI and ethics published by Springer turned out to have been created with AI and was also full of non-existent references. This is not a hypothetical future problem; it is happening right now.

Slop

In the Netherlands, hallucinating was the word of 2025. In English, Merriam Webster's dictionary also chose an AI term, slop:

digital content of low quality that is produced usually in quantity by means of artificial intelligence

AI slop is now creeping into every corner of the internet, as I wrote about before (only in Dutch: about my own paper, about a weird Dutch saying, and about the book the Camino). This could be (if you are generous) considered unintentional slop-piness, but in other cases, it is deliberately used for fake news, according to NRC.

Where you would expect large companies to resist the use of their content, I was completely surprised by the news this week that Disney is investing a BILLION in openAI, according to the always sharp blog 404 media in the slopification of their brand. This is particularly surprising because Disney traditionally allowed very little with their IP, for understandable reasons. But that is now over:

Disney [...] which has been notoriously protective of its intellectual property, opened up the video generator, saw the videos featuring Nazi Spongebob and criminal Pikachu, and decided: We want in.

OpenAI tried to prevent users in Sora from blocking content that was too similar to material from Disney (and other rights holders), but that is notoriously difficult, and so, according to 404, they must have thought “if you can't beat the slop, become the slop”. The investment not only means that you can synthesize Disney content on Sora and ChatGPT, but Disney will also publish it on their own channels. And it's not just Disney; StackOverflow, the question-and-answer site, is also collaborating with OpenAI, and the Washington Post (okay, maybe not really a bastion of good journalism anymore now that Jeffrey Jeffrey Bezos is in charge) is going to use AI to create personalized podcasts.

And who ultimately has to deal with all that mess? We will. The costs of that nonsense are passed on to users, not even so much the users of AI themselves, who are still aware that they are dealing with AI output and in theory still check everything, but to innocent users further down the chain who don't know what comes from AI and what doesn't:

[T]he cost of producing these outputs didn't disappear. It's just displaced onto the worker downstream of the AI user [...] The worker downstream now has no idea where errors might be hiding, which parts of the code or report were reliable and which risk being a hallucination.

The above is written by designer Pavel Samsonov in his newsletter. If you want to write as much content as possible as quickly as possible, you saddle other people with the obligation to check everything, and that destroyed reading for me.

Chatbots make mistakes, period. The evidence keeps growing. Trouw reported this week that even the best chatbot (Gemini 3) only get a third of their answers right, and nobody cares. AI grifters who want to sell books continue to babble on LinkedIn about "responsible use" and "better prompting", but you can't prompt something that gives random wrong answers.

I'm not the only one saying this; researchers at Carnegie Mellon are writing about it too. Prompting by describing a persona such as "play a super-critical reader" "does not improve model performance across a range of questions compared to the control setting where no persona is added". The effect of these prompts is "largely random". Yes, stochastic parrot is gonna stochast...

The solution is therefore not technological, Samsonov concludes.

This is not a technology issue; no amount of model improvements will make this okay. It is an ethics issue, and the only way to fix it is to fix your heart.

The real solution may not be technology, but technology can help! Are you fed up with all the fuss about AI? Install this plugin that changes every mention of AI into one about basketball player Allen Iverson.

The pain of knowing it could be better

Wow, what a piece this is! Written by programmer Raf, about how it feels when you constantly think about all the software you use: this could be better. I think it's especially relatable if you're a programmer yourself.

Especially the piece Technical Capability as a Moral Weight, where you constantly feel that everything that doesn't work is not okay:

Those things are not just questions, they are accusations. And, unfortunately, they do not stop.

It's like I wrote at the beginning of the year (Dutch), I see a nice new tool for learning letters and I immediately have to try it out to see if it works in Arabic, and if it doesn't, I understand why and I get really annoyed.

And the sad thing is that even people who can create do so very little. I recently spoke to my friend Fenia Aivaloglou, who worked as a programmer for years, and who complained that when you put your child in front of a smart TV, they are tempted to binge-watch endless rubbish. Unlike in the past when we watched dumb-TV, the list of new episodes is never depleted.

What I want, she said, is for my son to be able to choose from three options, a curated collection, so no auto-recommendations. And just like in the old days: when it's over, it's over, the program ends, and the software just stops. Maybe music starts playing, or a counter counts down to the next episode, or a fun puzzle or quiz or something. She immediately started fantasizing further: maybe you could share curated collections with other parents who are friends.

Until I said: but Fenia, you have a PhD in computer systems, right? You could put this together in an afternoon! (PS: do you think this is a cool idea? Fenia would love to get in touch with you via her LinkedIn!). But that just didn't really occur to her, because so few people, even those who can do it, actually do (Dutch). One reason is that it is very difficult to actually get your software onto your smart TV. Those ecosystems are usually closed, and it's a lot of hassle to get anything done.

But to be honest, I don't always think about actually programming things myself, it's boring! You may have noticed that for the past two weeks there have been links behind each header when you hover over them (the pink # sign):

I've wanted those for a long time, because without that button, if you want to deep link, which I often do, you have to retype the URL by hand and change spaces to dashes, like this: question-from-a-reader-how-is-your-newsletter-different-from-a-paper-or-a-tweet. If the header is long, that's a lot of work.

Now, a good friend of mine happens to work at Ghost (which is not really a coincidence, because they are the reason I am on Ghost!), and I asked him if he could make that for me. Well, he said, maybe you can do it yourself! I really needed that encouragement to get started. And in the end, it wasn't that difficult. After a little searching, I found an idea on their forum with a code example.

Great, I can just enter that into the 'code injection' feature. But that means you have to know that there is such a thing as entering code in Ghost, and how to do it. You have to divide the codes into css code for formatting and code for functionality. If you don't know that, you won't be able to enter the example.

But oh dear! When I did that, my site suddenly looked really strange, everything was super narrow. I had to read again carefully what I had pasted into my website without looking.Ah yes, of course, it says maximum width 500 pixels. I was able to figure that out quickly because I know that body refers to the content of your site and that 500px isn't that wide. Why is there code about the width of the page when what I want to do is add a link? Oh, I see, otherwise the example doesn't look as nice, but in a real-life setting you don't need it.

body {

max-width: 500px;

margin: 1rem auto;

padding: 2rem;

font: 300 100%/1.6 system-ui;

}

Ok, this should work. No... nothing has changed yet! Blergh. Now what? A 'normal person' with a website would probably get stuck now, because there's no way to see why it's not working. So you already need to know that most browsers have a 'developer mode' that lets you look under the hood.

And that's where I saw the reason it wasn't working: an error! Uncaught ReferenceError: $ is not defined Why is that? $ has something to do with jquery, a way to read the structure (DOM) of the website with JavaScript. In the example, they don't load that code because CodePen already has it built in, but I have to do that.

StackOverflow knows the answer: I just need to link jquery! I read this answer and can immediately decide that yes, this is the likely cause; I've solved these kinds of errors before. But they assume again that I'm going to upload the JavaScript to my site. I could do that, but it's a hassle. I'd rather use a CDN, a place on the internet where codes are already available. So you need to know what a CDN is, why they are useful, and that you can trust the one from Google (mentioned further down the page), at least in the sense that it is unlikely to go offline.

I could go on, as the example relied on headings h3, but I have h2 on my site, and on my site the content is not called .article-content but .gh-content. I had to look that up again in programmer mode and write extra code to count what had already been found. I didn't like the 0.2 margin either, and I want the link aafter and not before the text, so I had to adjust the CSS. And then I saw an even better example on another Ghost site with a "hover over" so that the symbol only appears when you hover over the header with your mouse, so I stole the code from there using developer mode!

All in all, it took me an hour to insert a simple link icon on my site, but I was only able to do that because I already know a lot about web programming. LLM fans might say that a code chatbot would have done the job too, and maybe that's true, but certainly not in an hour, because if you don't know anything, you have to keep reading, searching, and figuring things out.

A simple "$ means jquery" takes me one second to figure out, but it could take half an hour of chatting if you don't know what you don't know and therefore don't know what to ask. "Prompt engineering" cannot go beyond knowledge already stored in your long-term memory.

And in Ghost, you can script, that is not at all true for all software! I am regularly annoyed by menus in an app where my favorite options aren't at the top, and I grumble at my screen that there's nothing I can do about it even if I wanted to, even if I could do it if I had access to the code.

So just seeing and knowing that things can be better is not enough; you need knowledge, but above all, you need access. Early computer pioneers believed that if you use software, you have the moral right to also get the code that you can then modify to your heart's content. That may sound absurd in today's completely closed digital world, but of course it works that way with most products. If you buy a pair of pants, you can cut them, tear them, or dye them. You can decorate your bicycle spokes with straws or paper, who's going to stop you?!

On the computer however, you are at the mercy of whatever the makers of the software happened to think was useful; a curse when you know how to make it all better, not only the software itself, but also the world.

Briefly about language bias in GPT

And that programming and the confidence that you can do it not only helps when I want to build something, but also when you want to understand something! German programmer Jonas Villwock asked GPT questions about health in German, but he kept getting links to English-language sources. Instead of thinking, "Hey, that's weird", he thought, "Hey, I'm going to dive into this to find out what's going on", using PeekAI, a tool that allows you (for a fee, it seems) to see what AI answers to questions, so you can find out if your "brand" is coming across well. Apparently, a kind of search engine optimization market for LLMs is emerging, but that's beside the point.

Villwock dove in and analyzed 600 sources from ChatGPT, Perplexity, and Google AI overviews. And what did he find? No surprise, of course, but English-language sources were given enormous priority, even if you're chatting in German. That's a problem because, as he writes on LinkedIn:

People can't verify information in their own language when it matters most.

And there are very few sites that are often recognized as sources; only 5% of domains appear in all three chatbots, and they are never scientific sources:

They skip the science and rely on secondary sources that have already simplified it.

Read his entire analysis on his blog, which also reveals major differences between chatbots. ChatGPT and Perplexity differ enormously!

Events

(Reminder!) Mark your calendars for events after the Christmas holidays (all in Dutch, sadly):

- January 16: At Onderwijsinzicht, organized by Kennisnet, I will be speaking about the impact of AI on learning. I gave a short interview beforehand!

- February 12: I will give a keynote speech at NWO Insight Out, a conference for women in science (STEM) organized by NWO. I will (of course!) talk about the culture of science and its effect on how we work and what we research in science.

- On March 26, I will speak at the Teachers' Day Digital Literacy. On that day, we will try to support teachers in shaping digital literacy at school.

Good news

I regularly criticize VU University Amsterdam, but there are also things we do really well, such as almost no longer collaborating with the fossil fuel industry. Fortunately, this is also evident from this very detailed analysis in Trouw. Unfortunately, there appear to be a lot of other universities in the Netherlands that are still involved with fossil fuels in one way or another.

The article is good, but even better is the accompanying interactive data visualization, in which you can click on different universities to see who serves which interests. And then you find a professor from Twente who wrote in Volkskrant that universities should not put their moral compass on hold for research, while his own research was funded by Shell. That, he wrote, would "benefit the debate, and thus education." Yes, and perhaps himself too, but the fact that he collaborated with Shell was not mentioned in that article. And that's just one example; the visualization shows countless others, but none from VU University Amsterdam, which makes me happy and proud!

And what also makes me happy... Even dedicated AI fans in programming are slowly coming around!

My former colleague Zef Hemel wrote a delightful piece about programming with an LLM. It's like vacuuming with a Roomba: yes, it does something, but if you want a clean house, you do it yourself. So perhaps it's no surprise that, according to research by BNR, there is still plenty of demand for programmers! Between 2020 and 2025, the demand for programmers and AI specialists in the Netherlands was twice as high as in the previous five years, with 18,000 vacancies.

Programmers aren't the only critical voices! According to the blog Extreme Tech, "almost nobody" uses CoPilot so Microsoft has to scale back its goals significantly, in some cases by 50%. This is mainly because people are using ChatGPT or Gemini and not because they are not using AI at all, but given how much the CoPilot features have been pushed in all Microsoft products lately (for example, those annoying pop-ups in Outlook summarizing your emails), it is still striking. Apparently, people are just not clicking on them!

AI does not seem to be solving any real problems in healthcare either, according to an article in Volkskrant this week about research by Erasmus University that reviewed no fewer than 1,263 papers on AI. Almost none of the ideas helped; 1,238 (98 percent) applications yielded nothing (Dutch). And you might say, it's good that people are trying, but of course this is not free, both directly—trying costs money—and indirectly—focusing all efforts on AI means that other, often simpler, ideas are not being tried.

More good news is that people are still pushing back against ugly AI slop. McDonald's withdrew their ugly ass slop advertisement after many complaints.

And finally, I don't write about it often because gestures at the world, but freedom in America is clearly going downhill, as is evident after the fifth year of Trump. How heartwarming that there are brave people, such as St. Susanna Parish Church in Massachusetts, who removed the figures from their Christmas nativity scene and replaced them with a poster saying "ICE was here", despite criticism from, among others, the archdiocese of Boston.

Bad news

There is no cloud, there is only someone else's computer. We know that, of course, but it is so user friendly to use sync your things! Let this story from Paris Buttfield-Addison be a reminder that you should always make your own backups on your own computer, because your access can be blocked at any time (Buttfield-Addison was able to access his files again after five days, possibly due to the attention he received for his post). Even at Meta, you are (of course) not safe. Instagram recently deleted dozens of accounts of queer people (Dutch).

What is also gone is Google's program to help women in their careers: the Techmakers program. Not only has it been abolished, but all their work has been removed from Google's website, indicating that it is not just about cost-cutting but also about image.

Wow, what an incredibly sad story. A young woman wanted an abortion, which was unsuccessful on the first attempt. During a second try, she was told, incorrectly as it turned out later, that the baby was no longer alive and that she would miscarry naturally. When that did not happen, she decided not to have another treatment and carried the baby to term. She filed a complaint with the medical disciplinary board, and during the hearing, the following absolutely crazy sentence came up:

I asked ChatGPT about the quality of the device, and ChatGPT says there is nothing wrong with it. I missed it, despite my more than thirty years of experience. (translated from Dutch)

The measles outbreak continues in the US, with most cases affecting unvaccinated children, which is so incredibly unnecessary.

Enjoy your Christmas foodstuffs!

Member discussion