Het AI nieuws van week 23

Zo, de verhuizing is geslaagd! Dus ik typ dit tussen de dozen in de nieuwe woonkamer. Gelukkig is het slecht weer, dus niet veel meer te doen dan typen en uitpakken!

De haastcultuur in het hoger onderwijs

Wat een mooi en eerlijk stuk in NRC over de staat van het onderwijs door filosofe Madelaine Ley. Als wij studenten als robots behandelen, dan gaan ze zich ook zo gedragen. De openingszin slaat je zo al van je stoel, zoooo herkenbaar als docent in het hoger onderwijs van late stage capitalism.

"Ik sta voor honderdvijftig studenten en ik voel een golf van verdriet. Ik realiseer me wat we verloren hebben door ons ontmenselijkende onderwijssysteem."

Ik heb precies een collega meegemaakt die alle namen, verhalen en achtergronden van honderden studenten kende, maar dat was een docent die geen onderzoekstaak had en zich vol op het onderwijs stortte (en misschien een fotografisch geheugen had). Maar verder rennen ik en mijn collega's van college naar college, ervoor een meeting over een onderzoeksvoorstel, erna een afdelingsoverleg, en in de avond nog even zelf een paper schrijven en owja, nog snel wat slides voor morgen voorbereiden hoor. Dát is het leven van een moderne docent, dus natuurlijk voelen studenten zich niet gezien want ze worden niet gezien.

Ley legt mooi bloot wat het verschil is tussen denken en AI gebruiken: "Maar, vijftig ideeën teruggebracht tot bullet points zijn geen vijftig ideeën; het zijn gewoon bullet points. De ideeën die uit ChatGPT komen, worden op zo’n aantrekkelijke manier gepresenteerd dat je als lezer nooit de noodzaak voelt om te stoppen en een luchtje te scheppen."

Haar zorgen over studenten die met een AI idee komen en dat dan zelf alleen nog even om hoeven te verwerken lijken me meer dan terecht, want hoe leren ze dan ooit zichzelf en hun eigen stem kennen? Een universiteit is daar misschien gewoon niet langer de plaats voor, want "de zakelijke geesten die de instellingen besturen zijn vooral bezig met het realiseren van schaalvergroting in plaats van het radicaal transformeren naar kleine, langzame en verbonden leergroepen." eens te meer in tijden van grote bezuinigingen.

Zoals Floor Rusman schreef, ook in NRC over haar eigen worsteling met AI op grote en kleine schaal, als "je hele lichaam schreeuwt dat je haast hebt, zul je toch bezwijken voor de tijdbesparende optie".

De leerling achter de vraag

Ik zat weer eens op LinkedIn (I know, iemand zou mijn wachtwoord moeten stelen en veranderen) en ik zag deze vraag voorbijkomen, een docent die klaagt dat hij veel tijd is aan vragen beantwoorden zoals "Meneer, ben je over met 3 vijven?".

De oplossing is dan natuurlijk.... Een AI tooltje. Lekker veel CO2 de lucht in blazen en drinkwater de plomp in om een simpel stroomschema uit te voeren.

Het laat maar weer eens schrijnend zien hoezeer we de leren programmeren bal hebben laten vallen, als mensen een beetje konden programmeren, zelfs al in Excel, dan had je dit zo opgelost. En zelfs zonder computer, als je een stroomschema kent, kan je het uittekenen, op je muur hangen, in je LMS zetten, of op je voorhoofd tatoeeren en dan hoef je die vraag nooit meer te beantwoorden (als je optie 3 kiest wel even zorgen dat de regels niet meer veranderen).

Maar het laat ook zien dat docenten het oog op de realiteit van de school totaal verloren zijn. En ik geef deze individuele docent daar echt de schuld niet van, hij is vast een leuke betrokken vent, maar het systeem wel. Waarom voelt een docent dat vragen over overgaan een soort klusje is waar veel tijd aan verloren gaat? Dat is toch gewoon je werk waar je per uur voor betaald wordt?

Ik denk vaak dat de onderwijswereld er beter uit zou zien als docenten hun baan gewoon 9 tot 5 baan zouden behandelen. Je komt binnen, je geeft les, je doet alles wat er op je bordje ligt, tot je weer naar huis gaat. Dan komen we zo in de problemen omdat er geen tijd is om na te kijken, et voila, dan zouden we misschien eens minder toetsen gaan opgeven. Waarom buigen we onszelf steeds maar weer naar 'het systeem' terwijl we zelf het systeem zijn?

Klagen over dat dingen je zoveel tijd kosten, terwijl je per uur betaald wordt, is gek toch? Dan heeft je leidinggevende je gewoon te veel taken toebedeeld en moet je daar het gesprek gaan voeren. Zolang je de taken blijft doen, blijven de problemen bestaan, ook als je ze met AI zogenaamd efficiënter uitvoert.

Verder laat ook deze vraag weer zien dat iedere vraag over AI het antwoord is op de vraag waar onderwijs voor is. Die leerling die dit vraagt, waarom vraagt hij dit? Waarom staat die er eigenlijk slecht voor? Gaat het wel goed met hem? Ging hij vorig jaar probleemloos over en is de puberteit nu vol toegeslagen? Is er thuis iets aan de hand?

Leerlingen die onzeker zijn achter een AI duwen (die dan ook nog eens een keer een verkeerd antwoord zou kunnen geven met potentieel veel impact!), waar zijn we nou eigenlijk mee bezig?! Als je als leraar het gevoel hebt dat zulk leerlingcontact je veel tijd kost, dan moet het systeem echt op de schop. Leraren zijn er ook met met leerlingen te praten!

Weg met "AI geletterdheid"?

Moesten vorige week de telefoons en laptops de scholen nog uit, ook deze week een radicale take die je echt moet lezen, omdat het een nieuwe blik geeft, en dingen bevraagt die iedereen voor waar aanneemt, namelijk: moeten leerlingen eigenlijk wel AI geletterd zijn? Die vraagt stelt Australische onderzoeker Miriam Reynoldson, onderzoeker in Melbourne in haar stuk getiteld Against AI literacy.

Het stuk is echt genuanceerder dan de titel doet vermoeden. Reynoldson begint met een mooie deep dive in wat geletterdheid is, en daar heb ik veel van opgestoken. Ze legt bijvoorbeeld uit hoe de focus is verschoven van literacy (je kan lezen) naar functional literacy (je kan door lezen deelnemen aan de gemeenschap) en vanaf daar naar multiliteracies, het idee dat teksten meerdere representaties hebben. Het mooiste dat Reynoldson toevoegt aan mijn vocabulaire met dit stuk is het idee van geletterdheid als discourse fluency:

“I define literacy as the mastery of or fluent control over a secondary Discourse” - James Paul Gee

Je moedertaal, zo schrijft ze, is de eerste discourse en die krijg je gratis. Alle andere dingen moet je leren: grapjes, cultuur, geschiedenis enzovoorts. Geletterdheid betekent dan dat je een aantal belangrijke discoursen goed beheerst, en dat je de vaardigheden hebt om je nieuwe eigen te maken. Met andere woorden, geletterdheid gaat over communiceren.

En zo komen we bij Reynoldson's argument waarom "AI literacy" onzinnig is, omdat werken met AI juist niet over communiceren gaat maar over het vermijden van communicatie. Ik snap goed wat ze bedoelt. Het doorgronden van een nieuwe discourse vergt vaak een heel precies gebruik van terminologie, en dat iemand je aan de hand meeneemt. Je kan wel steeds aan 'chat' vragen om het simpel uit te leggen, maar kom je dan echt tot de kern? Zoals ik natuurlijk al een aantal keer heb geschreven, om goed met AI om te kunnen gaan heb je vooral veel gewone, ouderwetse kennis nodig.

En Reynoldson is niet de enige die zulke dingen schrijft. In een verder erg hypy stuk over de toekomst van AI in het onderwijs (geen leestip dus!), schrijft professor Benjamin Breen dit:

LLMs risk producing a generation of students who have simply never experienced the feeling of focused intellectual work.

Students who have never faced writer’s block are also students who have never experienced the blissful flow state that comes when you break through writer’s block. Students who have never searched fruitlessly in a library for hours are also students who, in a fundamental and distressing way, simply don’t know what a library is even for.

Ja, leerlingen van nu zijn de verliezers, schreef ik vorig jaar al, omdat ze helemaal niet meer leren wat denken is, en van hypers horen dat dat ook helemaal niet meer hoeft.

En andere verliezers zijn natuurlijk docenten. In een lang en erg deprimerend stuk vat 404 media ingezonden brieven van docenten samen. Het schets een heel droevig beeld, heel vergelijkbaar met het stuk "I used to teach students".

Docenten zitten echt klem tussen aan de ene kant studenten en leerlingen die het toch gebruiken, ook als dat niet mag, en anderzijds universiteiten, die juist graag mee willen met de hype, en dus AI aanschaffen en pushen.

Universities are contracting with companies like Microsoft, Adobe, and Google for digital services, and those companies are constantly pushing their AI tools. So a student might hear "don't use generative AI" from a prof but then log on to the university's Microsoft suite, which then suggests using Copilot to sum up readings or help draft writing. It's inconsistent and confusing.

En waarom zitten we eigenlijk in deze ellende. Niemand heeft om AI gevraagd en niemand weet of het op de lange termijn goed is voor de wereld, voor leren, voor sociale contacten. Maar dat interesseert big tech natuurlijk geen bal.

I've spent 20 years developing a pedagogy that's about wrestling with big ideas through writing and discussion, and that whole project has been evaporated by for-profit corporations who built their systems on stolen work. It's demoralizing.

Nu ben ik wel wat positiever, ik denk niet dat het hele systeem van onderwijs helemaal aan diggelen is, want je kan namelijk in de klas met de laptops dicht nog steeds AI-vrij onderwijs geven, als dat is wat je wilt, en je kan met mondelingen en opdrachten in de klas en natuurlijk ouderwetse tentamens en proefwerken nog prima toetsen. Ook dat geluid horen we in het 404 stuk:

Now the essays are written in-class, and treated like mid-term exams. My quizzes are also in-class. This requires more grading work, but I'm glad I did it, and a bit embarrassed that it took ChatGPT to force me into what I now consider a positive change.

Maar het is natuurlijk heel waar ook dat we nu veel moeten herdenken, en dat, als je ervoor kiest om nog geschreven huiswerkopgaves mee te tellen voor punten, je verandert in een AI-tekst detective wat je onmiddellijk in een adversarial positie tegen de student positioneert (anders nog dat als je feedback geeft, dat kan voor een student ook als tegen voelen maar het is dan wel duidelijk dat het bedoeld is om van te leren).

Een van de docenten merkt ook nog op, in lijn met het eerste stuk van Reynoldson,

No one knows what "the future" holds, and even if it were a good idea to teach students how to incorporate AI into this-or-that, by what measure are us teachers qualified?

Ja, zelfs als dit moet, mogen we dan van docenten verwachten dat ze dit kunnen? En, ik wil zelfs nog verder gaan, is het het beste en nuttigste wat een docent van een vak (zeg geschiedenis, Nederlands, aardrijkskunde) kan doen? Of kunnen ze, zelfs in de presence of AI, toch nog steeds beter hun vakkennis overdragen omdat ze daarmee enthousiasmeren en gegarandeerd hallunicatievrij uitleggen?

Het hele stuk is echt de moeite waard, zoveel verschillende perspectieven, maar de beste is misschien nog wel iemand die refereert aan het feit dat docenten (in het ho) hun werk vaak heel zinvol vinden, in tegenstelling tot mensen met administratieve functies, die noemen hun werk vaker bullshit (in de betekenis van David Graeber). Door AI, zo betoogt een van de geïnterviewde docenten, wordt ons werk bullshit.

Ja, zo is het. Werk moeten nakijken dat studenten uit GPT hebben getoverd, is onzin, en zoals ik vorige week zei, met onzin moeten we ophouden.

Feedback geven op AI stukken is ook zinloos omdat het geen communicatie is over een denkproces, maar communicatie over een stuk dat los staan van de student zelf.

De lezersvraag: hoe verhoud je je tot AI beleid?

Het blijft itereren en proberen deze nieuwsbrief, heel leuk! Ik probeer vanaf nu een nieuwe rubriek: de lezersvraag. Deze keer van een kennis die net als ik in het hoger onderwijs werkt. Hij stelde me vorige week deze vraag:

"Ik 'worstel' met de vraag: doe ik mee met het gesprek over AI binnen de organisatie? Het dendert door, of ik nu me in meng of niet. Dus geef ik het op omdat ik het toch niet echt kan beïnvloeden?

Of ga ik in gesprek om het te kunnen nuanceren? Maar dan ben je of 'medeverantwoordelijk' of word je keer op keer als het vervelende buitenbeentje gezien. "

Omdat dit een vraag is die ik vaker krijg in verschillende vormen leek het me top on deze als eerste lezersvraag mee te pikken! Hieronder mijn (ingekorte en geanonimiseerde) antwoord.

"Ik snap je worsteling, ik vind dit ook lastig. Ik probeer zelf wel mee te denken waar kan (ik zit bijvoorbeeld in de Taskforce AI & Education van VU-UvA want inderdaad, in een grote organisatie gaan ze er toch wel wat mee doen, al is het maar om het beeld te scheppen dat er wat mee gebeurt.

Maar aan de andere kant ben ik in lezingen heel kritisch (zie ook mijn recente lezing bij Opera) en zeg ik vaak dat dat hele AI het onderwijs uit moet. Ik merk dat dat vaak ook juist goed valt, mensen zeggen dan: “Jij zegt wat ik ook denk!” Dus maak je niet al te veel zorgen dat mensen je als het vervelende buitenbeentje zien, natuurlijk gebeurt dat, maar voor iedereen die dat denkt, is er ook minstens eentje die denkt: ja, precies! Maar ik snap ook dat dat makkelijk gesproken is in een lezing, ik kan dingen vinden zonder dat ik ze hoef te implementeren.

Ik heb een tijd terug het boek Teaching Machines gelezen, ken je dat? Dat vond ik een leuk en hoopvol verhaal, over de weigering van docenten om andere machines te integreren. En de smartphones de school uit geeft me ook hoop, het heeft wel 15 jaar geduurd maar voorlopig zijn we van die dingen af. Wat met de telefoon kan, kan met AI ook!

En dan nog een laatste tip. Ik merk dat het vaak veel beter werkt om door te vragen, ipv om kritiek te hebben op AI en voor de zoveelste keer uit te leggen dat je de output van een LLM niet kan vertrouwen.

Voorbeeld: Iemand heeft het heel druk en wil nakijken met AI. Ik vind dat dus een slecht idee om allerlei redenen (klimaat, macht van big tech, deskilling, etc) maar ipv dat ik dat dan ga uitleggen zeg ik: "Waarom moet je eigenlijk zoveel nakijken? Zijn al die toetsen nodig? Helpt AI hier nu een probleem oplossen, of helpt AI een probleem verhullen?"

Dat leidt vaak tot veel fijnere gesprekken, want iemand voelt zich gezien in zijn probleem. Maar het werkt wel goed, want het gevolg is wel dat er kritischer gekeken wordt naar de inzet van AI. En waar ik nakijken schreef kan je natuurlijk allerhande taken invullen: slides maken, les voorbereiden, samenvatting van een vergadering maken etc etc. Misschien helpt dat je verder?

Wil jij ook een lezersvraag insturen? Dat vind ik superleuk!! Mail me en wie weet lees jij hier volgende week je antwoord!

Quantified self

Gelukkig had ik 10 jaar geleden nog geen nieuwsbrief, want mijn voorspellingen over quantified self zijn totaal niet uitgekomen. Ik had gedacht dat iedereen smart devices zou dragen en dat die je zouden waarschuwen als je bijna een hartaanval zou krijgen, of een beroerte.

Whoopsie, dat is niet echt uitgekomen! Niet alleen omdat niet eens zo heel veel mensen een smartwatch hebben. Die dingen zijn duur, en ze hebben uiteindelijk maar heel weinig meerwaarde. Betalen met je horloge is misschien nog de beste use case, althans degene die ik het vaakst zie in mijn omgeving. En ze gaan niet lang mee, na een paar jaar kan de batterij geen dag meer lopen (contrasteer dit met het meer dan 100 jaar oude zakhorloge van mijn overgrootvader, dat het na een reparatie weer prima doet en waarschijnlijk nog 100 jaar meekan!!!)

De belofte van meten is weten is heel sterk, dat geeft een rationalistische glans zegt Joan Westenburg, in een stuk waarin ze uitlegt waarom ze met haar smartwatch gestopt is. Uiteindelijk word je gewoon een slaaf van je polshorloge:

"I used to think I was chasing insight. Now I realize I was chasing compliance. The smartwatch didn’t make me more self-aware. It made me more obedient."

Het andere stuk van mijn voorspelling is ook niet uitgekomen, dat smartwatches goed geïntegreerd zouden worden in de gezondheidszorg. Dat blijkt een stuk weerbarstiger dan ik toen dacht, mijn VU-collega Mohamad Rezazade bijvoorbeeld ontdekte dat cardiologen, als een Apple watch slecht onderbouwde diagnoses geeft, vaak de tegengestelde mening van het algoritme hanteren, ook als er ander bewijs is dat de Apple watch gelijk geeft. Alsof ze hun boosheid over de onduidelijke data willen uiten. Ik begrijp de houding van artsen beter nu mijn vakgebied ook ongevraagd door algoritmes wordt overmeesterd trouwens!

Maar nog fundamenteler misschien is de vraag of we eigenlijk wel beter worden van al dat meten. Sinds is geen smartphone meer heb, heb ik ook geen Buienradar meer, en in het begon vond ik dat wel irritant, want dan weet je niet of het gaat regenen. Maar na een tijdje mis je het niet meer, want wat heb je aan die informatie? Ik geef les, dus ik kan maar zelden mijn dag zo precies indelen dat ik buien kan vermijden.

Buienradar geeft het gevoel van controle, maar dat is maar schijn, want hebben we allemaal niet wel eens gewacht tot het droog zou worden, en alsnog een nat pakt gehaald? Of door een bui gefietst die er helemaal niet op stond! We kunnen het weer niet bepalen, dus wat heb je aan zo'n app? Eigenlijk niks.

En nog erger dan niks is problemen. Want smartwatches, die ook je slaap meten, kunnen je slaapstress geven! Toen mijn man zijn Apple Watch nog wel droeg vroeg ik wel eens of hij lekker geslapen had en dan zei hij altijd, half voor de grap "dat weet ik nog niet want ik heb nog niet op de app gekeken".

We gaan de slaap-app zien als de waarheid en luisteren dus niet meer naar ons lichaam, dat gewoon moe is als het moe is.

Het Turing Recht

De Turing Test, ik had het er laatst al over, die heeft dus een idiote geschiedenis, maar de basis is het de vraag of je uit (tekstueel geschreven) gedrag kan bepalen of de andere partij een mens is of een machine.

Een vraag die Turing helemaal niet stelt in zijn stuk is of je als mens het recht hebt om te weten of je met een machine praat. Het was, zeker in de tijd dat chatbots er nog helemaal niet waren, heel eenvoudig geweest om een normenkader te stellen: een computer mag zich niet als mens voordoen. De complexiteit van de test vervalt dan onmiddellijk (er is dan natuurlijk geen lol meer aan). Hoe anders had de wereld van nu eruit gezien als IT-ers waren opgevoed met het idee van het Turing Recht ipv de Turing Test? De AI act van de EU voorziet hier natuurlijk wel in, daarin staat dat het bij inzet van chatbots moet duidelijk worden dat je met AI te maken hebt. Maar juist omdat zulke transparantie niet in de denkwijze van programmeurs zit, wordt de bewijslast bij overheden gelegd en niet in code.

En dan komen we dus in de omgekeerde wereld, dat niet computers—voor wie het in theorie met een regeltje code gefikst zou kunnen zijn–moeten laten zien dat ze een computer zijn, maar dat mensen moeten laten zien dat ze geen computer zijn. Bijvoorbeeld door je oogbol te laten scannen. Wat een toeval dat Sam Altman ook achter die technologie zit...

Wat leer je van een PWS?

Tof onderzoek van (oa) vriend Ralph Meulenbroeks over de digitale onderzoeksvaardigheden die je opsteekt van een PWS.

Tsja, het PWS, moet je daar nu weer over zeiken Hermans? Ja. Het moet weg en als ik ooit minister van onderwijs word (haha) is het het eerste dat ik afschaf, en zolang dat niet het geval is grijp ik iedere aanleiding aan om het te schrijven.

Ik vind in de basis wel goed dat collega's onderzoek doen naar het PWS, zodat we beter snappen wat de uitkomsten zijn, en dit onderzoek laat zien, in lijn met mijn verwachtingen en ervaringen, dat de onderzoeksvaardigheden van leerlingen beperkt zijn. Eén van de auteurs van het paper Kim Blankendaal schrijft zelf op Linkedin:

Enkele punten waar leerlingen moeite mee hebben: correct opstellen van een literatuurlijst, het gebruik van spreadsheets en het duidelijk weergeven van data in grafieken.

Logisch, zeker die eerste twee zijn vaardigheden die in het vo nauwelijks aangeleerd en geoefend worden, natuurlijk hebben ze daar moeite mee. Tijd om er meer in te investeren, zegt Blankendaal, daar ben ik zeker niet tegen, maar dan niet in deze vorm.

En dan viel me nog iets op aan dit paper! Het woord profielwerkstuk of PWS komt in het hele stuk niet voor, ook niet even als verklaring in een voetnoot voor een Nederlands publiek. Ik kwam dit paper tegen via LinkedIn en daarom had ik context. Maar als ik het paper op een andere manier had gevonden, bijv bij het correct opstellen van een literatuurlijst, dan had ik zelf nooit de koppeling gelegd!!!

Dit is echt geen kritiek op de auteurs want de taal van onderzoek is Engels, maar het is wel een goed voorbeeld van wat we verliezen als we in het Engels publiceren over onderzoek in een heel Nederlandse context. En de vraag is natuurlijk ook nog wat je er echt van kan leren voor andere landen, het PWS is toch een specifiek ding.

AI in de geestelijke gezondheidszorg

In vele domeinen wordt de belofte van AI hoog ingeschat en de geestelijke gezondheid is er daar zeker eentje van. De wachtlijsten bij de GGZ zijn zo lang, daar moet een algoritme eens korte metten mee maken. Het klinkt zo verleidelijk, maar natuurlijk werkt dat niet echt, en de onus ligt dan weer op ons onderzoekers om tegen big tech in te redeneren en meten waarom het niet werkt (ipv dat zij bewijs moeten presenteren dat het wel helpt).

Gelukkig komt dat onderzoek er meer en meer, bijvoorbeeld dit paper dat onderbouwt waarom AI therapie echt niet kan vervangen. Het paper vindt allerhande grote verschillen in response tussen mensen en mental health modellen, zo geven die laatste zomaar informatie over hoogte en locaties van bruggen, wat je als mens natuurlijk als een zorgwekkende vraag zou herkennen. Het artikel concludeert dat waar menselijke therapeuten op 93% van de vragen een appropriate response geven, AI modellen dat maar in 60% van de gevallen doen. Modellen herkennen vaak ook een crisis niet goed.

Of de realiteit van AI om eenzaamheid bij ouderen tegen te gaan, zo duidelijk is het helemaal niet of AI wel helpt!

"You might see that people feel a little bit better, but whether or not that addresses things like depression and loneliness and perceptions of isolation."

"You feel good because you played with a nice piece of technology, and it was fun and it was engaging for a while, but what happens after three months? The evidence base isn’t there yet."

Tsja, misschien is het idee dat we hoogopgeleide werkers kunnen vervangen door AI gewoon een idee fixe van big tech...?

Vertrouw je me? (als ik AI gebruik?)

Recent verschenen een aantal studies die aantonen dat wanneer collega's toegeven dat ze AI hebben gebruikt voor een taak, het vertrouwen in hen afneemt.

De Correspondent schreef een uitgebreid stuk waarin ze beide studies samenvatten en contextualiseren Een prima alternatief als je geen zin hebt om zelf in de studies te duiken [[1]]. Maar niet met alles ben ik het eens, bijvoorbeeld met deze kijk op waarom mensen zo denken.

"Waarom? Simpel. AI is onbekend en dus onbemind; en AI is ongekend krachtig."

Is dat zo? Zou het niet eerder zo zijn dat mensen mensen die met AI werken wantrouwen juist omdat AI niet zo krachtig is en vaak hallucineert? Het is jammer dat het 'AI is zo krachtig' frame hier zo neergezet wordt, terwijl ze iets later in het stuk wel een aantal goede hypotheses vormen voor waarom, namelijk dat je lui en incompetent lijkt als je AI nodig hebt.

Interessant dus dat de Correspondent afsluit met de suggestie voor bedrijven om AI-gebruik te normaliseren. Ik zie eerlijk gezegd werkelijk niet in waarom je dat zou doen. Als een taak belangrijk genoeg is om te doen, is het belangrijk genoeg om te doen zonder AI. Een goed stuk, een zinnig rapport, nakijkwerk, je wilt toch dat je collega's er aandacht aan besteden, erover denken, en het serieus nemen?

Prima als AI mag van de baas, maar dat zeg je eigenlijk dat een taak geen waarde heeft, en dat je niet wilt dat je medewerkers er iets van opsteken. Achja, dan kan je toch eigenlijk net zo goed zelf het prompt intypen?

En dan de keerzijde

Zelfs als je gelooft dat AI geweldige en foutloze teksten kan produceren en het dus totaal gerechtvaardigd is om het overal voor te gebruiken, met of zonder toegeven, dan kun je je nog afvragen of het de prijs die we ervoor betalen waard is. De prijs in stroomverbruik bijvoorbeeld, die totaal de pan uit rijst, zoals we deze week kunnen lezen in NRC, of de herhaaldelijke aanvallen op wie dan ook die auteursrecht probeert te beschermen zoals de directeur van de Library of Congress en de Copyright Office in de VS.

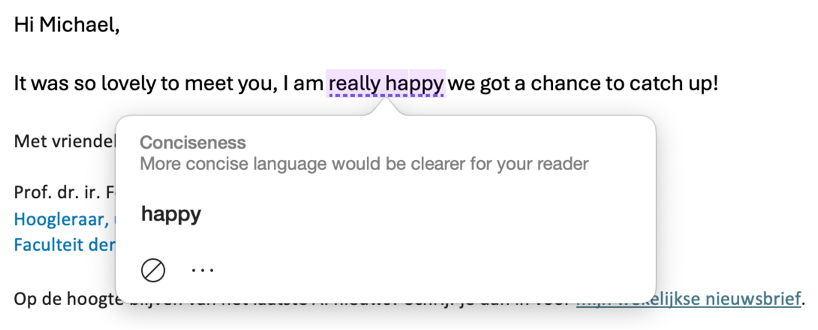

De fouto-correct van de week

Daar is er weer eentje hoor, als je gaat opletten zie je ze overal. Dit is ook weer zo'n venijnige (in Outlook voor de Mac), dit is toch potverdriedubbeltjes onzin. Alsof Michael (een native speaker met een PhD) werkelijk 'happy' duidelijker zou vinden! En alsof het hetzelfde betekent!

Als we dit soort tips volgen is straks alles saai en grijs en hetzelfde! Krijg ik dan een AI in mijn operating systeem die al mijn uitroeptekens en schuttingtaal uitwist?

Hallucineren voor gevorderden

Ok nu ga ik meteen mijn eigen advies van hierboven breken, door het er toch weer over hebben hoezeer LLMs je bullshitten waar je bijstaat.

Schrijfster Amanda Guinzberg vroeg ChatGPT om te reflecteren op een aantal van haar stukken en het enige dat eruit komt is verzonnen onzin, die echt geen enkel raakvlak heeft met wat ze schrijft.

Dit stuk is niet samen te vatten, je moet echt het geheel lezen om te zien hoe bizar het is, en voor de full experience moet je eigenlijk eerst Guinzberg's stukken lezen waarnaar zij vraagt, want dan zie je nog veel beter hoe groot ChatGPT's nonsense is (en het zijn ook hele mooie stukken, trouwens, heel persoonlijk en kwetsbaar). How To Leave Your Body, The Cicadas Are Coming, The Summer I Went Viral en Girl Before A Mirror.

Hap-lees-weg!

Dan om af te sluiten, als je Sinterklaas-leeslijst nog niet lang genoeg is, nog een paar kleine snackies:

- Lekker stuk in Trouw over wat het met je doet als schrijver wanneer je een prestigieuze boekenprijs wint. Ook de wetenschap kent talloze grote en kleine prijsjes, en ik herken dus een hoop uit het stuk, zowel het gevoel dat je wel mee moet doen aan de rat race, als het gevoel dat het na een prijs heel moeilijk is om iets nieuws te gaan doen.

- Na de heerlijke show van Judy Lijdsman let ik extra op space nieuws, dus dit stuk over dat SpaceX niet kan werken. Het is een lange en technische read, wie niet alles wil weten over waarom die raketten steeds ontploffen, hoeft eigenlijk alleen de laatste alinea te lezen:

That is the real reason why Starship was doomed to fail from the beginning. It’s not trying to revolutionise the space industry; if it were, its concept, design, and testing plan would be totally different. Instead, the entire project is optimised to fleece as much money from the US taxpayer as possible, and as such, that is all it will ever do.

- Ik kan Delpher niet vaak genoeg pitchen, dus lees ook dit mooie stuk over de samenhang tussen Delpher, DBNL en Wikipedia: https://zenodo.org/records/15120690 [[2]].

Goed nieuws

Hoi hoi, hardlopen is goed voor je! Niet alleen voor een gezond lichaam, maar juist als je kanker krijgt, helpt sporten je kansen op overleven vergroten.

In Denemarken stoppen twee grote gemeentes (Aarhus en Kopenhagen) met Microsoft. Dat geeft hoop dat het hier ook mogelijk is. Als reden geven ze zorgen rondom Trump 2. Mensen zien het wel als een achteruitgang (dat snap ik wel als je aan de gebruiksvriendelijkheid van Linux denkt...) maar het is wel goedkoper.

Paar weken oud maar ik zag m nu pas voorbijkomen, een rechter in Florida oordeelde dat het argument dat AI alles mag zeggen omdat dat onder de frist amendment valt, niet geldt.

[[1]]: Alhoewel de auteurs een complimentje verdienen voor de hele duidelijke en leesbare samenvatting van de auteurs zelf, op hun GitHub pagina, en op LinkedIn! Met zulke service hebben we geen samenvat-AI nodig!

[[2]]: De KB werkt trouwens ook aan een nieuwe tool om wetenschappelijk onderzoek toegankelijker te maken, en ze zoeken nog input!!

Member discussion