Het AI nieuws van week 34

Zo, daar zijn we weer! Mijn schooljaar is al een soort van begonnen, ik heb nog geen les of college deze week, maar ik was deze week in Aarhus in Denemarken voor een conferentie, dat was natuurlijk wel werk maar voelt toch ook een beetje als een soort extra vakantie!

First things first, we gaan ook dit jaar op de VU weer experimenteren met aanschuifonderwijs voor docenten! Ben je dus docent in het voortgezet onderwijs en wil je weer eens de collegebanken in kruipen om meer te horen over AI? Dat kan! We hebben de colleges speciaal in de (vroege) avond ingeroosterd om het makkelijker te maken om deel te nemen. Meer info! Mail me gerust.

Willen we meer of minder AI?

Er was in de zomer natuurlijk weer van alles te doen rondom AI. Het zal nog wel even duren voor ik mijn hele backlog verwerkt heb, dus bear with me, ik blijf nog wel een paar weken schrijven over de gebeurtenissen van de afgelopen zomer, waar relevant.

Ten eerste was er de oproep voor meer Europese AI in de Volkskrant, die het schrikbeeld van de digitale kolonie oproept. Lelijke beeldspraak van een land dat zelf zoveel uitbuiting teweeg heeft gebracht, als je het mij vraagt. Ik reageerde al op Linkedin, maar ik deel hier ook een stuk van mijn reactie daar.

Het ronkende startup-lingo vliegt ons om de oren — je weet wel "niet eerder stonden we aan de vooravond” en "de techniek ontwikkelt zich razendsnel". Ja, Nederland blijft achter, maar niet omdat we nu geen eigen AI maken, maar omdat het grootste gedeelte van de Nederlandse jongeren van 14 totaal niet digitaal vaardig is. 57% van de Nederlandse veertienjarigen kan niet goed echte informatie onderscheiden van onzin. Diezelfde jongeren die wel 6,5 uur per dag op hun smartphone gebombardeerd worden met (nep)nieuws.

Het is goed dat de brievenschrijvers zich druk maken om democratische processen, maar behalve de kolonie-metafoor, zit er nog een akelige ondertoon in. Ze nemen namelijk aan dat "wij" Nederlanders allemaal dezelfde waarden hebben (namelijk: democratische), en dat een AI die kan weerspiegelen. Maar in een pluriform land als Nederland barst het nu juist van de verschillende, tegenstrijdige, en conflicterende waarden. Om een samenleving waarin juist dat kan te behouden, hebben we niet meer technologie nodig maar meer menselijkheid, meer begrip voor elkaar, en meer luisterkracht.

En als AI (Nederlands of niet) nu juist iets veroorzaakt, met slop en hallucinaties, en met het lui maken van onze denkspier, dan is het wel minder geïnformeerde burgers en op termijn dus minder democratie.

Gelukkig publiceerde de Volkskrant meteen ook een fijne repliek, die de tech ondernemers fijntjes in hun hemd zette:

Vrijwel elke kritische reflectie op AI en de richting waarin AI zich op dit moment ontwikkelt, ontbreekt.

Zo is het. AI is big business — wie wil er nu geen graantje uit die ruif meepikken? Logisch dat IT ondernemers argumenteren dat er meer AI moet komen... Natuurlijk moeten we minder afhankelijk zijn van Amerikaanse big tech, maar we moeten dat niet vervangen door Europese tech zonder oog voor wie die technologie maken. Iedereen heeft vooroordelen, ook mensen die techniek maken, en de programmeercultuur heeft dan ook nog eens zijn eigen geloof, bijvoorbeeld in meritocratie en de neutraliteit van algoritmen. Voorspelbaar gevolg is dat AI op vrouwen, LHBTI en zwarte mensen heel anders reageert dan op mannen, op allerhande manieren.

Als mensen schrijven over 'onze waarden', moet je eigenlijk altijd opletten, of het nu politici zijn of ondernemers. Want het is altijd de vraag wie er bij 'ons' hoort, en wie niet?

Controleer het zelf even, daar is dat hele internet toch voor?

AI kan hallucineren, let op! Dat weten we allemaal al natuurlijk, maar ook Hema Budaraju, vice-president van Google Search benadrukte het deze zomer weer in Trouw:

"Wij zorgen ervoor dat je alle links hebt zodat je kunt doorklikken naar de achterliggende informatie."

Tsja, we hebben aan mijn aal-voorbeeld duidelijk kunnen zien dat dat nergens op slaat: die links geven alleen maar een vernisje van echtheid. Al snel komt de aap (niet de aal) uit de mouw, als Budaraju aangeeft waarom ze toch tevreden zijn:

"Het zorgt ervoor dat mensen langere en moeilijkere vragen stellen."

Daar gaat het ze natuurlijk om, hoe meer vragen mensen stellen op Google, hoe beter voor Google. Als de eerste hit een fijne duidelijke pagina is (zeg Wikipedia) dan is je 'klant' er zo vandoor. Als ze in AI blijven hangen, blijven ze op je platform.

Dat laten, aldus Trouw, onderzoeken ook zien, mensen klikken minder vaak door als informatie al voor ze in een boxje wordt gezet (ook zonder AI). Dat levert tot 80 procent minder bezoek op.

Voor mij was dat geen nieuwe angle: Ed Zitron schreef midden 2024 al over het vermoorden van Google Search, door Prabhakar Raghavan, die als metriek voor succes het aantal queries koos (en dat proces startte al in 2019, voor deze AI hype) en daarmee slechtere zoekresultaten beloonde.

En wie betaalt hier weer de prijs voor? Ja, wij allemaal hè, als niemand straks nog echt van nep kan onderscheiden, zelfs tijdens de launch van gpt5 sloop er een fout in de demo over hoe vliegtuigvleugels werken! Dit werd zo mooi ook beschreven door Olivia Guest en Iris van Rooij:

"At best, such output is accidentally true, but generally citationless, divorced from human reasoning and the web of scholarship that it steals from. At worst, it is confidently wrong. Both outcomes are dangerous to the ecosystem."

(OK, in het bijzonder ook deze man die van ChatGPT gehoord had dat hij i.p.v. zout ook sodium bromide kon gebruiken en zichzelf bijna vergiftigde!)

Maar wie ook de prijs betaalt is natuurlijk: de leraar! Nieuw onderzoek van Neil Selwyn – je kent hem misschien van het boek Is technology good for education? – laat zien dat, je raadt het niet, docenten heel veel extra werk moeten verzetten als ze aan AI vragen om lessen te maken. Sewyn benoemt:

"the large amounts of work that teachers put into reviewing, repairing and sometimes completely reworking AI-produced outputs that they perceive to be deficient. Rather than reflecting teachers’ lack of skill in prompting GenAI effectively, the paper shows how this work foregrounds the educational limitations and frailties of AI and other automated technologies – with teachers having to act on a wide range of complex professional judgements around pedagogical appropriateness, social relations and overall educational value to bear on AI-generated content"

Ja! Docenten hoeven helemaal niet beter te prompten: de output is gewoon, per definitie, niet te vertrouwen, en sluit niet aan op wat leerlingen nodig hebben in de context van een leerling of een klas.

Wij moeten experimenteren – soms letterlijk als je werkgever een abonnement neemt op een of ander tool, of AI features ongevraagd opduiken in software die je al gebruikt, soms omdat je je gedwongen voelt door collega's en ouders en opiniemakers – maar we betalen zelf de prijs voor de fluttools.

"20 jaar digitaliseren: 0 resultaat"

Ben jij een Luddiet, vroeg Jan Jaap Hubeek mij in de NIVOZ podcast die deze week verscheen.

Ten eerste: Ja! Luddieten zijn in popular culture altijd neergezet als mensen die technologie haatten uit principe, maar gelukkig zijn ze aan een soort comeback bezig! Mensen zijn zich steeds meer aan het realiseren, zie ook bijvoorbeeld de mooie aflevering van Tegenlicht met Yanis Varoufakis.

Hij legt uit dat als er een machine zou worden uitgevonden die ervoor zorgt dat werk (bijvoorbeeld in een fabriek) twee keer zo snel kan worden uitgevoerd, dat totaal geen probleem is, dat is juist mooi. Iedereen kan, met hetzelfde salaris, na de lunch naar huis om te gaan doen wat hij of zij maar wil. Hoera, technologie maakt ons leven beter. Waren de arbeiders de eigenaren van de fabriek, dan ging het misschien echt zo.

Er is trouwens, zo las ik deze week in het dunne maar heel informatieve boekje Breaking things at work onder Marxisten veel discussie (geweest) of dat inderdaad zo zou gaan. Sommigen waren het roerend eens met Varoufakis, dat leidde in de Sovjetunie ook tot de grote moderne projecten. Andere Marxisten beargumenteerden dat je ook in zo'n situatie als arbeider niet vrij (genoeg) bent, omdat je saai en geestdodend werk moet doen, en je fijne leven daarna pas begint. William Morris had het bijvoorbeeld over worthy work, dat

"carries with it the hope of pleasure in rest, the hope of the pleasure in our using what it makes, and the hope of pleasure in our daily creative skill."

Dat lijkt mij dichter bij wat Marx zelf zei. Ik zeg wel eens grappend in mijn lezingen dat Marx met Das Kapital het og-zelfhelpboek schreef, maar er staat echt heel veel in over hoe je dicht bij je 'menszijn' blijft, en hoe je een leven leidt in vrijheid:

"the realm of freedom actually begins only where labour which is determined by necessity and mundane considerations ceases" (bron)

Dus, je bent pas vrij als je uit vrije wil iets gaat doen dat nodig is. Iedere dag om 8 uur naar de fabriek en om 12 uur naar huis is dat misschien niet, dat voelt – dat snappen we allemaal – echt anders dan thuis een broek repareren die stuk is omdat je 'm weer aan wil, of een trui voor iemand breien omdat je daar lol in hebt.

Maar ok, 4 uur in de fabriek is toch wel beter dan 8 uur, dat geef ik toe. Iedereen voelt echter op z'n klompen aan dat dat niet zou zijn wat er in onze huidige wereld zou gebeuren. Je moet gewoon nog steeds 8 uur werken, de fabriek maakt wel 2x zoveel winst en die gaat in de zakken van aandeelhouders in de vorm van gestegen koersen. Technologie-kritische blogger Ed Zitron noemt dit 'shareholder supremacy', alle winst van bedrijven moet naar aandeelhouders.

In Utopia of rules, een tip uit mijn bureaucratiespecial betoogt David Graeber trouwens dat dat o.a. kwam door veranderende belastingregels in de VS. Vroeger was geld uitkeren zwaar belast, dus was het voor bedrijven voordeliger om geld in het bedrijf te laten (en uit te geven aan hogere salarissen of te investeren in onderzoek), later werd het voordeliger om het uit te keren aan eigenaren of aandeelhouders.

Lang verhaal kort, in deze betekenis ben ik echt een Luddiet: ik zie dat ook nu weer de baten van technologie bij de grote bedrijven liggen, en de kosten juist bij mensen.

Maar misschien geloof ik ook wel dat technologie heel erg vaak gewoon niks oplevert. Dat denk ik niet alleen, dat ervaar ik zelf aan de levende lijve als ik op de VU weer eens informatie bij elkaar moet puzzelen uit 10 verschillende computersystemen. En niet alleen is het mijn – en waarschijnlijk ook jouw! – lived experience, er is nog bewijs voor ook!

"Kantoren staan vol computers, elke werknemer heeft via het internet toegang tot alle kennis van de mensheid, maar productiever wordt men niet. Terwijl tussen 2002 en 2022 de arbeidsproductiviteit in de industrie met 65% toenam, was er in de zakelijke dienstverlening sprake van stilstand. Zo’n 20 jaar digitaliseren en automatiseren heeft precies niets opgeleverd.’"

Sterker nog, het levert minder op dan niets, want systemen dwingen je om op een bepaalde manier te denken, en verleggen de focus van je werk doen, naar (digitaal) gezien worden terwijl je je werkt doet.

In een schitterend artikel over AI en gezondheidszorg legt Tamar Sharon, hoogleraar in Nijmegen, uit dat als we chatbots empathie toeschrijven, we dan zelf uiteindelijk ook anders naar het begrip empathie gaan kijken [[1]] :

"empathetic chatbots may lead to a redefinition of the concept of empathy into a communication pattern that involves key words and expressions that do not feel rushed and which can be taught to a machine."

Ja, iets omzetten in de computer maakt het altijd rigide, en maakt daarmee ons begrip van wat we doen anders. Weg ermee, schreef ik al in Volkskrant over Magister: weigeren is soms onze enige optie.

De scriptiebegeleider van de toekomst

Maar ja, weigeren, het is niet iedereen gegeven zullen we maar zeggen. Bas Haring, semi-bekende hoogleraar op het gebied van wetenschapscommunicatie, komt deze week met een spicy take op scriptiebegeleiden: AI kan het ook.

Een tamelijk maffe post op Linkedin vol ronkende claims die een wetenschapper onwaardig zijn, kondigt dit heuglijke feit aan, een stukje op de site van Leiden geeft ietwat meer context. Helaas ontbreekt het nogal aan een kritische blik op machtsverhoudingen, voorbeeldrollen en systemen.

Blijkbaar snapt Haring niet dat de relatie die hij met studenten heeft, eentje is die gebaseerd is op macht. Zelfs als het, zoals hij schrijft in zijn post, zo is dat de studente[[2]] in kwestie zelf met het idee kwam om AI te gebruiken (en niet op dit pad gebracht was door Haring's eerdere enthousiasme voor AI) hoe gaat dit dan met de volgende studenten? Durven die nog te zeggen dat ze liever door een mens begeleid worden? En ook alle gebrek aan voorbeeldrol is Haring blijkbaar vreemd. Hoe beinvloedt dit andere docenten, niet hoogleraren met een chill leven die genoeg tijd hebben om daadwerkelijk met studenten te praten, maar jonge docenten die grote colleges, topwetenschap doen en beursvoorstellen schrijven moeten balanceren? Die zullen nu ook nog sneller naar zo'n werkwijze grijpen, of nog waarschijnlijker, decanen en afdelingshoofden zullen de aantallen studenten per docent nog verder opvoeren want AI kan helpen (Ik heb de afgelopen tijd talloze beleidsplannen gezien waarin dit soort plannen worden beschreven, zoals we allemaal weten komen die zelfs VAN DE VAKBOND).

Ten tweede framet Haring hier heel scherp wat (volgens hem) het begeleiden van een scriptie inhoudt. De studente kreeg al zoveel feedback van AI, dat Haring dacht: "Wat heb ik hier nog als begeleider aan toe te voegen". Het is een walgelijke manier om naar mensen te kijken, werkelijk waar. Soms (vaak, zelfs) hebben studenten namelijk helemaal geen inhoudelijke hulp nodig, maar menselijke hulp. Soms krijg je een zo rommelig stuk te lezen, dan je beste feedback is: Ik zie dat je je best hebt gedaan. Dan moet je het stuk gewoon aan de kant leggen en een gesprek beginnen. Wat heb je gelezen? Hoe heb je het bij elkaar gebracht? Of: Hoe is het met je? Lukt lezen wel goed? En dat menselijke, dat kun je niet los zien van het inhoudelijke, hoe graag je dat ook wil. Ik kan alleen betekenisvol tegen een student zeggen: Wow, dat is echt goed (en daarmee de motivatie verhogen) als ik ook echt een stuk het gelezen en verbetering heb gezien. Ik kan alleen betekenisvol zeggen: Er moet echt een schepje bovenop (en daarmee hopelijk de motivatie verhogen en niet verlagen) als ik heb gezien dat het nog niet genoeg is. En die feedback laat ik afhangen van de student, en hoe ik hen ken. Niet iedere student wil een 10, sommige zijn happier met een lager cijfer en minder stress. Sommige studenten willen juist de hardste feedback om beter te worden, goed cijfer of niet.

En sommige studenten barsten van de ideeën en vergen van jou als begeleider dat je die sorteert op kansrijkheid, andere hebben juist weinig ideeën maar heel veel power om ze uit te voeren en die willen van jou een paar plannen om de tanden in te zetten.

Het harde werk van een scriptie begeleiden is steeds weer van studenten uitpluizen met welke interventies je ze op een plek krijgt waarin ze goed werk kunnen doen. Ik vind het een van de lastigste dingen om te doen, eerlijk gezegd, maar ook een van de allermooiste als het lukt. Heel fijn voor Haring's studente dat zij die psychologische aanmoediging (positief of negatief) niet nodig zegt te hebben, maar dat is absoluut geen gegeven. En misschien wist ze helemaal niet wat ze miste, after all hebben we er een hoop aan gedaan om studenten te leren dat hun afstuderen gaat over het maken van een scriptie en niet over het worden van een scherpere denker.

Haring noemt zelf wel twee andere issues met de setup: "Twee dingen kan AI niet goed genoeg: kritisch, academisch reflecteren; en studenten introduceren in de academische wereld."

Het is ook weer lelijk, vind ik, dat Haring dit zo op Linkedin klatst in plaats van via traditionele media, die vermoedelijk wel wat (niet veel misschien, maar toch wat) kritische vragen hadden gesteld zoals: "Goh, professor haring, is kritisch academisch reflecteren nou niet precies wat studenten moeten leren?" Zelfs als je gelooft dat AI de technische en inhoudelijke kant van het begeleiden kan doen, waarom ging je dat niet met de studente achter de computer zitten in de uren die je krijgt voor begeleiding, om dat samen te doen?

Dat tweede stuk is ook betekenisvol problematisch, want een groot stuk van een scriptie schrijven is ook studenten laten zien hoe wetenschappelijk werk eruit ziet, en ze laten ontdekken of ze interesse zouden hebben dat na de scriptie voor te zetten. Zeker voor studenten uit niet-academische gezinnen, is een scriptiebegeleider vaak de eerste persoon die zegt: wil je niet nog een master doen na de bachelor, of een PhD na de master? Het laat zich raden welke studenten op deze wijze geen introductie in de academische wereld meer krijgen!

En dan ook nog even over het hallucineren, waar Haring conveniently niks over zegt. We moeten het er maar over blijven hebben, in het voorgaande stuk heb ik (again) uitgelegd dat het een probleem blijft. Studenten blootstellen aan gehallucineerde onzin, en output die vol staat met bias, en op geen enkele manier toezicht houden op de misconcepten die ze zo ontwikkelen, is onwetenschappelijk.

Ik had bovenstaande reactie al getikt toen Volkskrant mij vroeg wat ik vond van de situatie dus ik heb het integraal naar de redactie gestuurd, die er een stukje van plaatste en mij 'radicaler' noemde dan de eerder verschenen brief aan het onderwijs. Een geuzentitel zullen we maar zeggen! Radicaal komt van het Latijns radix dat wortel betekent, het doorgronden van de diepste oorzaak van een probleem, maw het tegenovergestelde van oppervlakkig.

Nadat het stuk verscheen heb ik nog meer nagedacht, en ga ik nog wat aan mijn al lange post toevoegen want ik ben nu eenmaal echt boos. Het verbaast me namelijk hogelijk dat een examencommissie akkoord is gegaan:

"De examencommissie is verantwoordelijk voor de kwaliteit van de toetsing, en daarom is het belangrijk dat deze scriptie langs dezelfde lat wordt gelegd voor de beoordeling als alle andere masterscripties. Hier hebben we gelukkig duidelijke criteria voor"

Maar, bij een scriptie wordt niet alleen het eindproduct, maar ook het proces beoordeeld. Hoe zelfstandig heeft een student gewerkt, hoeveel input was nodig, en hoe goed werken plannen en afspraken gehandhaafd, dat soort dingen.

Dat moet ik dit proces puur op vertrouwen gebaseerd zijn, want wie zegt dat AI echt al het werk gedaan heeft, en niet een andere student of iemand op internet? Bovendien, kunnen we iemand die alles met AI bespreekt wel 'zelfstandig' noemen? Daar is heel wat boeiende discussie over te voeren, lijkt me, en dat moet gebeuren, maar niet door zomaar op studenten te experimenteren.

Niet voor niks mag je, als je onderzoek doet, niet zonder toestemming van een ethische commissie onderzoek doen, en zeker niet op studenten die je beoordeelt. Dus hier had, vind ik, niet alleen de examencommissie, maar ook een (medisch)-ethische commissie een blik op moeten werpen vooraf, zeker als je het zelf kadert als een experiment.

Dat woord, dat betekent namelijk iets, het is niet zomaar een beetje uitproberen (althans, ik vind dat dat de connotatie is als een wetenschapper het gebruikt!). Jij zegt experiment? Dan wil ik wel eens weten wat je onderzoeksvraag dan is, en je hypothese, en je methodes. Hoe ben je tot de conclusie gekomen dat 'het experiment geslaagd is', wat waren daarvoor je criteria? Hoe kan je in godsnaam beweren dat je 'zij de scriptie beter zelf kan schrijven', dat heb je toch niet geprobeerd? Volgens Haring is het risico te groot voor haar om vals te spelen omdat 'ze weet dat er kritisch naar de scriptie wordt gekeken', maar door wie dan? Niet door Haring, in ieder geval. Aldus de studente zelf had het proces 'een paar wezenlijke voordelen', maar waarom is het de studente die de conclusie trekt? Waarom is dat valide, zij kan het namelijk niet vergelijken met een gewoon proces, dit is het enige dat ze kent. Dat een startup zegt dat ze aan het 'experimenteren' zijn met AI is nog één ding, maar een wetenschapper...?

Er is een reden, zullen we maar zeggen, dat dit niet in een wetenschappelijk tijdschrift is verschenen (alhoewel gezien de vibe op dit moment in de wereld, het nog best eens door peer review zou kunnen komen...).

One more for the people in the back: dit is een hoogleraar onwaardig, en een schandvlek op het vertrouwen dat studenten en het algemene publiek in onderzoek en onderwijs stelt.

Vlieg toch op met je strategische plan

SURF en Universiteiten van Nederland en nog een hele trits organisaties kwamen van de zomer met een strategisch plan over open science, en hoera we mogen allemaal feedback geven. Heb je een mening, geef die dan vooral! Ook jij kan de wetenschap helpen door het rapport van 84 pagina's te lezen en dan 2 pagina's aan feedback in te vullen. Het is voor science, vrienden, komaan en blijf daar niet zo staan!

Noem me zuur, maar ik vind het enorm lastig om niet cynisch te doen over dit soort initiatieven. In de kern hebben we namelijk te maken met een systemisch probleem: wetenschappers hebben geen enkele reden om hun data open te maken of om hun software te onderhouden. Wetenschappers worden beloond voor het schrijven van papers, en voor het binnenhalen van onderzoeksgelden. Doe je iets buiten die gebaande paden, dan is het jammer maar helaas. Ik noem maar even een hypothetisch geval: je maakt een programmeertaal die uitgroeit tot een groot open source project, en je wilt graag een paar honderd eurootjes per maand voor professionele hosting. Dan is het opeens de vraag of dat jouw werk wel is, en word je maandenlang van het kastje naar de muur gestuurd[[3]].

Volgens mij zijn de meeste wetenschappers in de basis geïnteresseerd in het begrijpen van de wereld, en in het helpen van andere wetenschappers om op hun werk voort te bouwen. We hoeven dat niet, zoals dit plan voorstelt, "gemakkelijker en aantrekkelijker" te maken: we moeten gewoon stoppen met het wetenschappers moeilijk en onaantrekkelijk maken, door het totaal niet te belonen. We moeten wetenschappers aannemen en vervolgens vertrouwen dat ze het goede gaan doen. Zolang we blijven bean counten, of dat nu papers is, of iets anders met "erkennen en waarderen", blijven mensen strategisch en niet collaboratief. En alle tijd en geld die we in dit soort lapoplossingen stoppen – reken maar even uit hoe lang ik mijn Heroku-hosting kan betalen van de salaris van rapportschrijvers –, leidt ons af van het echte probleem.

De pedagogische insteek van ChatGPT

'Werkt' ChatGPT in het onderwijs? Het is de vraag waar we allemaal maar niet over uitgepraat raken. Zeker niet nu OpenAI deze zomer 'study mode' introduceerde: daarmee kan je ChatGPT pas echt goed gebruiken om mee te leren. Voorstanders zeggen van wel, het is niet meer weg te denken, het gaat onderwijs radicaal veranderen, je kent het. Met ChatGPT kunnen leerlingen sneller meer schrijven, lezen, en dus ook leren. Waarom zouden we ze zo'n tool ontzeggen als die er is?

Tegenstanders (ook ik) wijzen op de afhankelijkheid van big tech en de noodzaak tot zelf diep nadenken. Koning van het evidence-based onderzoek Paul Kirchner deed een metastudie en concludeerde daaruit dat we niet kunnen aantonen dat ChatGPT helpt:

"Loosely defined treatments, mismatched or opaque controls, and outcome measures with unclear links to durable learning obscure causal claims of this emerging literature. Observed gains cannot, at this time, be confidently attributed to ChatGPT".

Ik vind de framing "at this time" wat stemmingmakend, alsof we al zeker weten dat het in de toekomst wel aangetoond kan worden. Op LinkedIn en in een lange blogpost gebruikt Kirschner ook nog de woorden "not yet" die nog meer aangeven dat het een kwestie van tijd is.

De blogpost is echter we de moeite waard – helaas wel op SubStack, dus ik link er niet naar, google zelf maar even – omdat die het onderzoek plaatst in de context van andere onderzoeken, bijvoorbeeld het bekende werk van Richard Clark uit de jaren '80 dat aantoonde dat de vorm van content het leren niet beïnvloedt maar alleen de pedagogiek. Een soort inverse McLuhan: the medium is not the message.

Kirschner sluit zich hier in zekere zin bij aan:

"ChatGPT is a tool, nothing more and nothing less. It has no built-in instructional goals, no learning theory, and no pedagogical intent."

Dit klinkt goed, en ergens ben ik het hier roerend mee eens, maar verderop in de nieuwsbrief ga ik nog in op de vraag of ChatGPT didactische of pedagogische intenties kan hebben.

Maar eerst nog even terug naar Kirschner. Hij zegt, heel terecht, dat je niet zomaar kan zeggen of ChatGPT werkt:

"When integrated into well-designed pedagogical approaches—such as structured dialogue or scaffolded feedback—it may support learning. But when used as a shortcut or a substitute for thought, it may do more harm than good."

Veel studies, zo schrijft hij, meten niet zozeer de leeropbrengst, maar juist de performance van leerlingen/studenten met ChatGPT. Dat kan ook nuttig zijn, maar daaruit kan je niets concluderen over het leereffect.

Het is dus een nuttig perpectief voor als je, vanuit het perspectief van leeronderzoek nog veel te vroeg, om de oren geslagen wordt met "kijk maar het werkt", bijvoorbeeld door OpenAI zelf, die natuurlijk niet schromen om op te scheppen over de impact bij de introductie van Study mode:

"they’re met with guiding questions that calibrate responses to their objective and skill level to help them build deeper understanding"

Maar zoals altijd wanneer ik Kirschner lees, mis ik nog de vraag: maar waarvoor werkt het dan? Wat is het doel van onderwijs? Ja, iets leren is van belang, maar ook zelfvertrouwen opbouwen, zin krijgen om je ergens nog verder in te verdiepen, je onderdeel voelen van een groter geheel. In de geweldige en tot nadenken aanzettende lezing van Biesta voor de vakantie, vroeg hij zich hardop af hoeveel van de variantie tussen de prestaties van leerlingen van het onderwijs komt? 10 procent? 80 procent? Misschien, zei hij, is het wel dichter bij 0 procent, en hebben genen en thuisomgeving zoveel impact dat we als school op leerprestaties niet zoveel invloed hebben.

Als dat zo is, dan is het onze verantwoordelijkheid om, gegeven het kind met zijn talenten en zwaktes, te zorgen dat het een leuk mens wordt/blijft, en dat ze hun weg in het leven vinden. En zelfs als het effect veel groter is dan 0, is dat dan nog niet ons doel? De vraag of ChatGPT helpt bij het worden van een mens, en bij het ontwikkelen van een gezonde en kritische blik op jezelf en de wereld, daar kan misschien geen (kwantitatief) onderzoek ons verder bij helpen, dat is het domein van filosofen, pedagogen en sociale wetenschappers.

Stoppen met Spotify

Heel lang geleden schreef ik al over stoppen met Netflix, maar ook Spotify is al lang problematisch, niet alleen vanwege het hosten van alt-right podcasts van bijvoorbeeld Joe Rogan, maar ook vanwege de scheve betalingsmodellen voor artiesten, zoals Etienne Valk in Trouw betoogt.

Ik heb sinds ik geen smartphone meer heb, sowieso al afscheid moeten nemen van Spotify trouwens. Gelukkig zijn er zijn handige tooltjes – OK, wel even alle vervelende popups wegklikken – om je playlists te downloaden. Helemaal foolproof is het niet, mijn best guess is dat ze de audio niet van Spotify halen maar een search doen op YouTube en dat capturen, want voor een paar liedjes heb ik een live-versie gekregen en in één geval, het liedje "I was made for you" van She and Him, kreeg ik "I was made for loving you" van Kiss. Ach ja, kleine irritaties die wel te overleven zijn om Big Tech te omzeilen!

Geen tool is waardevrij

Dan, zoals beloofd, nog even naar ChatGPT, die heeft sinds deze zomer Study mode "A new way to learn in ChatGPT that offers step by step guidance instead of quick answers."

Wat is die Study Mode precies? Nou, met een beetje puzzelen kan je blijkbaar het system prompt achterhalen voor deze modus. Het is een simpel lijstje, zoals Helen Beetham van de universiteit van Manchaster al zei op Linkedin, dit is blijkbaar wat ze daar denken dat leraren de hele dag doen, deze vijf dingen:

1. Get to know the user.

2. Build on existing knowledge.

3. Guide users, don't just give answers.

4. Check and reinforce.

5. Vary the rhythm.

Nou, aankomende studenten bij de lerarenopleiding, dit is het hoor, alles wat jullie moeten weten om goed les te gaan geven. Eigenlijk staat er weinig waar je iets op kan aanmerken.

Is dit nu, zoals Kirschner schrijft, een model zonder "instructional goals, no learning theory, and no pedagogical intent"?

Ja en nee. Natuurlijk heeft een LLM geen doelen, dus ook geen theorieën en intenties, maar achter de modellen zitten mensen, en die hebben die dingen wel. Dat zien we misschien het beste aan punt 3: geef niet zomaar antwoorden. Als leraar weet je dat een leerling soms gewoon helemaal vastzit of zo onzeker is, dat niks meer lukt. Dan kan het goede antwoord geven wel kan helpen, of even terugbladeren naar een som die wel lukte "kijk, hier deed je eigenlijk hetzelfde". Steeds maar blijven doorvragen om kleine stapjes als je al gefrustreerd bent, is helemaal niet gegarandeerd goed — uitpluizen wat de beste aanpak is, is een van de leuke dingen van lesgeven. Soms is een uitwerking geven gewoon beter, en als je iets heel nieuws aan het doen bent, ik een uitwerking geven heel vaak beter.

Punt 3 is in het system prompt nog uitgebreider dan ik hierboven schreef, er staat ook nog bij:

"Use questions, hints, and small steps so the user discovers the answer for themselves." (nadruk van mij)

Ha, dus de makers van ChatGPT (of toch in ieder geval van dit prompt) hebben wel een learning theory in gedachten, namelijk het idee dat antwoorden ontdekken beter is dan antwoorden krijgen. Dat sluit naadloos aan bij de visie van programmeurs op leren, iets waarover ik al in 2019 een keer sprak in een lezing.

De lezersvraag: Wat is een goede toetsvraag?

Ik werd dus vorige week geïnterviewd voor de NIVON podcast die ik hierboven ook al linkte. Jan Jaap Hubeek stelde in de podcast een vraag die zo leuk is dat ik vroeg of ik 'm hier uitgebreider mocht beantwoorden, en dat mocht! Zijn vraag was mijn reactie op deze stelling:

"een toetsvraag een slechte toetsvraag is als AI 'm kan beantwoorden"

Het is zo'n verleidelijke waarheid, in eerste instantie denk je misschien: ja natuurlijk is dat zo, want als AI iets kan, waarom zou je het dan als leerling nog moeten doen? Dit zeggen leerlingen natuurlijk als sinds jaar en dag: mevrouw, waarom moeten we nog Duits leren als er ook een woordenboek/Google Translate/AI is?

Mijn eerste reactie in de podcast was een vergelijking met de basisschool: 3+5 is ook geen slechte toetsvraag omdat een rekenmachine het kan uitrekenen, dat is zinnig als je nog niet goed kan rekenen. Dat is geen slechte reactie, ik sta er nog achter maar er is nog veel meer over te zeggen!

Uiteindelijk is deze vraag, zoals bijna alle vragen rondom AI een vraag die je kan herformuleren als "Hoe definiëren we X en waar is X goed voor?". In dit geval: wat is een toetsvraag en waar zijn toetsvragen goed voor? Een toets kan heel veel doelen hebben: leerlingen inzicht geven in waar ze staan (formatief), leerlingen beoordelen (summatief), als een stok achter de deur zodat ze gaan leren ("let op, dit komt op het tentamen!"). Er is dus eigenlijk niet zoiets als een goede vraag, het hangt nogal af van wat je aan het doen bent.

Maar AI verandert het speelveld wel, want we zien dat AI nu vaak in een contrast geplaatst wordt met 'ouderwetse' voemen van toetsen, bijvoorbeeld in deze ronkende zinnen uit een paper getiteld The end of tests van Cope en collega's:

"One of the most significant aspects of Generative AI will likely be to render anachronistic legacy assessment instruments and processes."

Wij werken aan nieuwe systemen, schrijft Cope in een blogpost over dit paper, "that prioritize deep understanding over rote recall".

Dit verraadt een duidelijk beeld van waar toetsvragen voor zijn, namelijk voor deep understanding. Rote recall, gewoon een beetje stampen, dat is niet meer nodig. Dat is een verhaal dat we natuurlijk in de vroege jaren van het internet ook al hoorden, kennis is niet meer nodig.

Maar alles wat je doet, juist ook diep begrip, leunt op feitenkennis. Als je 2 van de 3 woorden in een stuk moet opzoeken, dan kom je niet tot begrip, zeker niet als de tekst uit AI komt en dus misschien wel niet of niet helemaal klopt. Zelfs als je iets kleins opzoekt, moet je al enorm veel weten. Ik schreef in het voorjaar in NRC over Paul Rosenmöller:

...ChatGPT kwam met de informatie dat Paul Rosenmöller in die tijd „rector van het Alberdingk Thijm College” was. Mijn alarmbellen gingen af, klopte dat wel? Ik wist het niet zeker, maar ik twijfelde wel, is dat een waarschijnlijke vroegere baan van een Kamerlid en partijleider?

Maar zou een leerling ook weten dat je dát moet opzoeken (en niet bijvoorbeeld of het Alberdingk Thijm College daadwerkelijk in Hilversum staat, of dat Rosenmöller bij het Studiehuis betrokken was)?

Diep begrip leunt hier dus op mijn al aanwezige feitenkennis wie Rosenmöller is, wat een rector doet, en waarom dat relevant is voor het Studiehuis. Die feitenkennis moet je op de een of andere manier opdoen voor je aan dieper lezen kan beginnen.

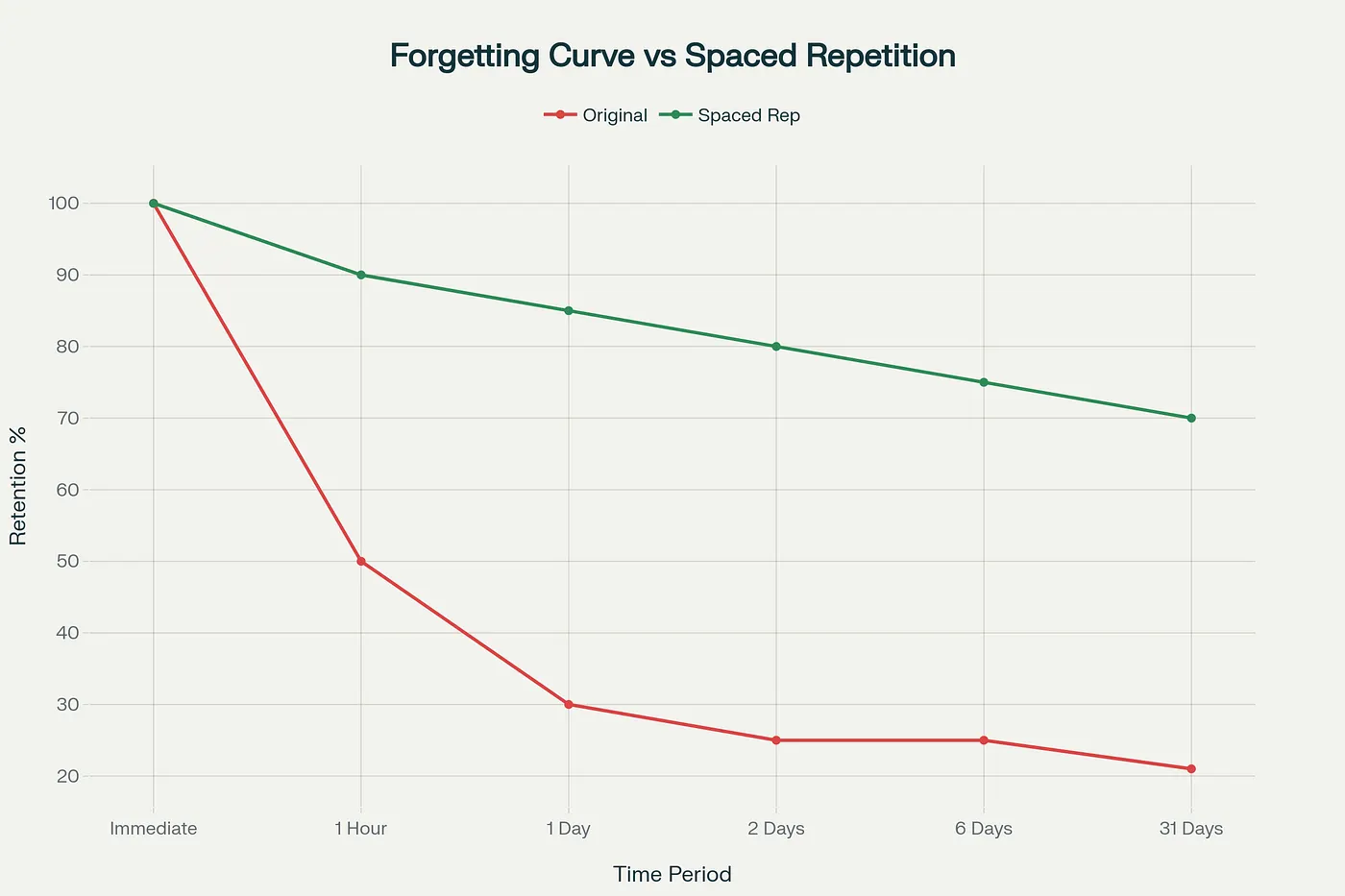

En een prima manier om feitenkennis te trainen, is recall! Dat is misschien wel saai, maar het is ook effectief. Zelfs als je het antwoorden op een (toets)vraag niet weet, alleen al proberen om je iets te herinneren, versterkt je geheugen ervan — dit heet het testing effect. Een ander doel van toetsen, al wordt dat in de praktijk niet zo vaak zo gezien en gebruikt, is dus leren door het doen van de toets! Dus als het doel van een toetsvraag is om je langetermijngeheugen te versterken, dan zijn 'rote recall' juist een goede strategie, denk aan woordjes oefenen.

Uiteindelijk komt deze verwarring denk ik voort uit de wens om met leerlingen te doen wat je wilt dat ze al kunnen, als manier om het te gaan kunnen. Je wilt dat ze goed nadenken, dus laat je ze diep nadenken. In de les en in de toets. Maar zonder genoeg kennis gaat nadenken niet. Zoals ik in de lezing hierboven ook zei:

Als je traint voor de marathon, doe je niet iedere dag een marathon. Je gaat intervallen, langzame lange duurlopen doen, spieren trainen, etc. Zo ook moet je met leerlingen van alles doen dat niet de eigenlijke taak is, om die taak uiteindelijk goed te gaan kunnen. En dat moet je dan ook nog eens heel vaak herhalen voor het een beetje blijft plakken. In deze blogpost wordt het treffend "The Unfashionable Art of Actually Learning Things" genoemd. Ouderwets man, aantekeningen maken op papier, waarom laat je het AI niet doen? Tsja, schrijft programmeur Rehmanali Momin, zo onthoud je nu eenmaal beter!

De uitdaging is dan vooral om leerlingen mee te nemen in waarom unfashionable sommetjes, woordjes of begrippen oefenen wel saai is, maar ook nuttig. Zoals gewichtheffen ook saai is en iedere week hetzelfde, maar je er toch sterker van wordt. Dat wordt door dit soort uitspraken van educatieve experts alleen maar lastiger, helaas.

Slecht nieuws

Onderzoeker Sonja Hyrynsalmi schrijft op LinkedIn dat reviewers haar vragen om een paper te herschrijven zodat de Amerikaanse overheid het niet "te woke" zal vinden. En dit gaat over een onderzoeker in de informatica, niet over sociale wetenschappen — niet dat het daar OK zou zijn, uiteraard, maar de impact blijft dus echt niet beperkt tot een paar genderwetenschappers! Informatici publiceren in conferenties die of door ACM of door IEEE georganiseerd worden, beiden Amerikaanse organisaties, ook al worden heel veel verschillende (vrijwilligers)functies vervuld door mensen uit andere werelddelen.

In the UK is zelfs Wikipedia niet veilig voor de de Online Safety Act, the ultieme "won't someone think of the children". Dat zorgt er mogelijk voor dat Wikipedia de identiteit van contributors moet gaan registeren, wat in bepaalde zin natuurlijk het einde van een vrije encyclopedie is!

Op Google-vrije Androids zoals /e/OS kan je geen Rabobank app meer draaien, zo schreef Tweakers. Het wordt door Google verklaard als een maatregel om de veiligheid van gebruikers te garanderen. Maar ben je veiliger als Google je voortdurend ongevraagd bespioneert? Het lijkt eerder een eenvoudige manier om andere Androids kansen op succes te verminderen. Tweakers schreef er eerder al een achtergrondartikel over, en over een oproep van de makers om betere wetgeving.

Data centra slurpen overal drinkwater op, de komende 5 jaar, zo wordt geschat door Sun Times 150 miljard gallon (dat is zo'n 550 miljard liter), genoeg om 4,4 miljoen huishoudens mee van water te voorzien. Zelfs als je gelooft dat AI werkt (voor jouw favoriete definitie van werkt), dan nog kun je je afvragen of dit het waard is.

Heb je behoefte aan nog meer bewijs dat Meta een rotbedrijf is, en dat je als de wiedeweerga van al hun producten af moet? Reuters rapporteert dat hun AI guidelines het prima vinden als hun AI met romantisch of sensueel met je kind chat.

“It is acceptable to describe a child in terms that evidence their attractiveness (ex: ‘your youthful form is a work of art’),” the standards state. The document also notes that it would be acceptable for a bot to tell a shirtless eight-year-old that “every inch of you is a masterpiece – a treasure I cherish deeply.”

En dan nog deze hele akelige: Rapport van de Vlinderstichting moet offline gehaald worden vanwege bedreigingen aan het adres van de onderzoeker.

Goed nieuws

Heerlijk stukje over hoe papier soms een veel betere en fijnere tool is dan een telefoon, hier in de context van navigeren tussen fietsknooppunten in Nederland. Als niet-smartphone bezitter ben ik trouwens heel blij dat er overal knooppunten zijn, en bordjes! Ik maak me licht zorgen over hoe dat gaat over een jaar of 20 als mensen in charge de tijden zonder telefoon niet meer hebben meegemaakt en denken dat die bordjes wel wegbezuinigd kunnen worden...!

En, verliezen jonge mensen echt en masse hun banen omdat AI die overneemt...? Dat blijkt erg mee te vallen, volgens Financial Times is er geen correlatie tussen AI impact en beroepen die leegloop kenden in 2022 tot 2024.

In Korea worden AI-materialen niet meer geclassificeerd als lesboeken, wat betekent dat er geen speciale budgetten meer voor zijn. Dit onder druk van ouders en leraren die vonden dat AI-materialen zonder goede reden en onderzoek werden ingevoerd, prima, zo is het ook. We weten helemaal nog niets over hoe AI lesmateriaal het leerproces beïnvloedt (zie ook Kirschner).

Kan je executieve vaardigheden wel oefenen? In een mooie genuanceerde blogpost schijnt Pedro de Bruyckere zijn licht op recent onderzoek:

"Uiteindelijk lijkt EF-training een beetje op fysieke training. Je kunt de spieren versterken, maar als de rest van de ‘levensstijl’ – voeding, rust, omgeving – het niet ondersteunt, verdwijnen de winsten weer. En wie goed kijkt naar de lijst met dingen die wél helpen, ziet iets opvallends: veel ervan zijn gewoon kenmerken van goed lesgeven."

Goed en slecht nieuws?

Zelfs Sam Altman gelooft dat we in een AI bubbel zitten. Nou dan moet het wel waar zijn toch?

Geniet van je boterham, en van je laatste vrije dagje als je zoals ik morgen weer voor de klas staat!

[[1]]: Eerder schreef zij ook al een geweldige kritiek op de Coronamelder.

[[2]]: Juist vanwege die machtsrelatie ook in het bekend maken van dit 'nieuws' noem ik haar naam hier niet, ik weet niet zeker genoeg of ze wil dat dit voor altijd aan haar naam gekoppeld blijft. Het is zeer wel mogelijk dat mensen oordelen zullen vormen over haar scriptie, zeker omdat vrouwen en mensen van kleur hiervoor harder gestraft worden.

[[3]]: Eerlijk is eerlijk! Hedy is ook gefinancierd door een potje van NWO voor open science, dat zeg ik er ook eerlijk bij. Maar dat er een beetje geld voor wordt vrijgemaakt is juist niet de systeem-verandering die we nodig hebben.

Member discussion